NVIDIA Grace Hopper Systems – các hệ thống tăng tốc sử dụng bộ xử lý mạnh mẽ, được đặt tên để tưởng nhớ đến người tiên phong trong lập trình phần mềm, sẽ được trưng bày tại hội nghị trí tuệ nhân tạo toàn cầu GTC 2024, diễn ra từ ngày 18 đến 21 tháng 3, sẵn sàng đưa tính toán lên một tầm cao mới.

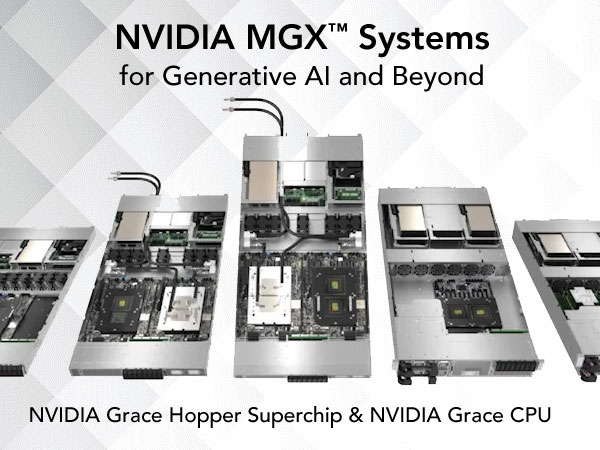

Những người sản xuất hệ thống sẽ trưng bày hơn 500 máy chủ trong nhiều cấu hình khác nhau trên 18 rack, tất cả đều đóng gói chip siêu mạnh NVIDIA GH200 Grace Hopper. Chúng sẽ tạo thành triển lãm lớn nhất tại gian hàng của NVIDIA tại Trung tâm Hội nghị San Jose, Khu vực MGX Pavilion.

MGX Tăng Tốc Quá Trình Đưa Sản Phẩm Ra Thị Trường

NVIDIA MGX là một bản thiết kế để xây dựng các máy chủ tăng tốc với bất kỳ sự kết hợp nào của GPU, CPU và đơn vị xử lý dữ liệu (DPUs) cho nhiều ứng dụng trí tuệ nhân tạo, tính toán hiệu suất cao và ứng dụng NVIDIA Omniverse. Đây là một kiến trúc tham chiếu modular để sử dụng trên nhiều thế hệ sản phẩm và công việc.

Những người tham gia hội nghị GTC có thể nhìn ngắm các mô hình MGX được tùy chỉnh cho doanh nghiệp, đám mây và sử dụng ở cạnh telco, chẳng hạn như suy luận trí tuệ nhân tạo, hệ thống đề xuất và phân tích dữ liệu.

Khu vực triển lãm sẽ trưng bày các hệ thống tăng tốc đóng gói chip GH200 Superchips đơn và kép trong các thùng 1U và 2U, kết nối thông qua DPU NVIDIA BlueField-3 và mạng NVIDIA Quantum-2 InfiniBand 400Gb/s qua cáp và bộ chuyển đổi LinkX.

Các hệ thống hỗ trợ các tiêu chuẩn ngành cho tủ rack 19 và 21 inch, và nhiều hệ thống cung cấp khe cắm E1.S cho lưu trữ không bay.

Dưới đây là một số mô hình MGX hiện đã có:

- MECAI của ASRock RACK, kích thước 450 x 445 x 87mm, tăng tốc dịch vụ trí tuệ nhân tạo và 5G trong không gian hạn chế tại lớp viễn thông của telco.

- MGX server của ASUS, ESC NM2N-E1, trượt vào một rack chứa đến 32 bộ xử lý GH200 và hỗ trợ các nút làm mát bằng không khí và nước.

- Foxconn cung cấp một loạt các hệ thống MGX, bao gồm một mô hình 4U có thể chứa tới tám GPU NVIDIA H100 NVL PCIe Tensor Core.

- XH23-VG0-MGX của GIGABYTE có thể chứa nhiều lưu trữ trong sáu khe cắm nóng 2.5 inch Gen5 NVMe và hai khe M.2.

- Các hệ thống của Inventec có thể chèn vào rack 19 và 21 inch và sử dụng ba thiết kế tản nhiệt chất lỏng khác nhau.

- Lenovo cung cấp một loạt máy chủ MGX 1U, 2U và 4U, bao gồm các mô hình hỗ trợ tản nhiệt bằng nước trực tiếp.

- Máy chủ AS201-1N0 có làm mát bằng không khí của Pegatron đóng gói một DPU BlueField-3 để mạng được định nghĩa bằng phần mềm và tăng tốc phần cứng.

- QCT có thể xếp chồng 16 hệ thống QuantaGrid D74S-IU, mỗi hệ thống có hai chip GH200, vào một QCT QoolRack duy nhất.

- ARS-111GL-NHR của Supermicro với chín quạt có thể thay thế nhanh chóng là một phần của một bộ sưu tập hệ thống có tản nhiệt bằng không khí và nước với chip GH200 và NVIDIA Grace CPU.

- SV7200H của Wiwynn, một hệ thống 1U với hai chip GH200, hỗ trợ DPU BlueField-3 và một hệ thống tản nhiệt bằng nước có thể quản lý từ xa.

- Các máy chủ MGX của Wistron là các hệ thống GPU 4U cho suy luận trí tuệ nhân tạo và công việc kết hợp, hỗ trợ lên đến tám bộ gia tốc trong một hệ thống.

Các máy chủ mới này được thêm vào ba hệ thống tăng tốc sử dụng MGX được công bố tại COMPUTEX tháng 5 năm trước – ARS-221GL-NR của Supermicro sử dụng CPU Grace và QuantaGrid S74G-2U và S74GM-2U của QCT được trang bị chip GH200.

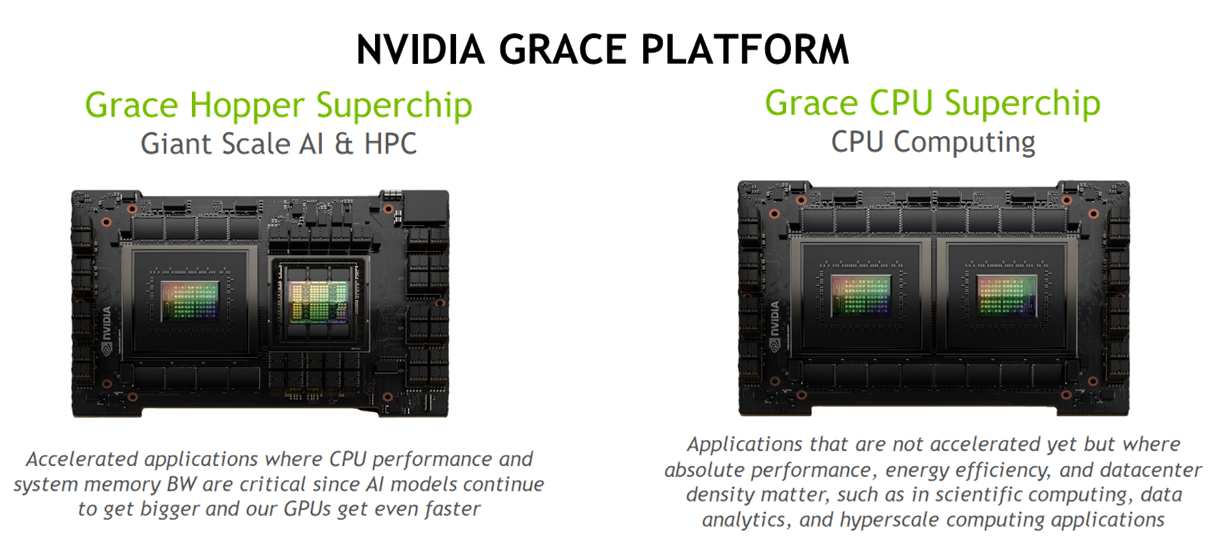

Grace Hopper Đóng Gói Hai Trong Một

Người xây dựng hệ thống đang áp dụng vi xử lý lai vì nó có sức mạnh.

Chip GH200 Superchips kết hợp một CPU Grace hiệu suất cao, tiết kiệm năng lượng với một GPU NVIDIA H100 mạnh mẽ. Chúng chia sẻ hàng trăm gigabyte bộ nhớ qua kết nối nhanh NVIDIA NVLink-C2C.

Kết quả là một bộ xử lý và bộ nhớ phức tạp rất thích hợp để đối mặt với những công việc đòi hỏi nhất hiện nay, như chạy các mô hình ngôn ngữ lớn. Chúng có bộ nhớ và tốc độ cần thiết để liên kết các mô hình trí tuệ nhân tạo sáng tạo với nguồn dữ liệu có thể cải thiện độ chính xác của chúng bằng cách sử dụng phương pháp tạo ra được bổ sung, còn được biết đến là RAG.

Hệ thống Đề Xuất Chạy Nhanh Gấp 4 Lần

Ngoài ra, chip GH200 Superchip cung cấp hiệu suất cao hơn và lên đến 4 lần nhanh hơn so với việc sử dụng GPU H100 với CPU truyền thống để thực hiện các nhiệm vụ như đưa ra các đề xuất cho mua sắm trực tuyến hoặc truyền phát truyền thông trực tuyến.

Trong buổi ra mắt trên các bảng xếp hạng ngành MLPerf vào tháng 11 năm ngoái, các hệ thống GH200 chạy tất cả các bài kiểm tra suy luận trung tâm dữ liệu, mở rộng hiệu suất dẫn đầu của GPU H100.

Mọi cách, các hệ thống GH200 đang đưa ra một cách mạnh mẽ cuộc cách mạng tính toán mà người đặt tên của chúng đã giúp bắt đầu trên các máy tính mainframe đầu tiên hơn bảy thập kỷ trước.

Đăng ký tham gia NVIDIA GTC24, hội nghị cho thời đại trí tuệ nhân tạo, diễn ra từ ngày 18 đến 21 tháng 3 tại Trung tâm Hội nghị San Jose và trực tuyến tại đây

Và hãy xem cái nhìn toàn cảnh từ CEO và người sáng lập NVIDIA Jensen Huang trong bài diễn thuyết chính của ông tại GTC24.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale