NVIDIA MGX là gì?

NVIDIA MGX là một kiến trúc máy chủ mô-đun (modular server architecture) được NVIDIA tạo ra để giúp các nhà sản xuất hệ thống xây dựng các máy chủ hiệu suất cao cho trí tuệ nhân tạo (AI), điện toán hiệu năng cao (HPC) và các tác vụ đám mây một cách nhanh chóng và tiết kiệm chi phí.

Thay vì phải thiết kế một máy chủ từ đầu cho mỗi nhu cầu cụ thể, MGX cung cấp một bộ khung và các thành phần cốt lõi đã được tiêu chuẩn hóa. Các đối tác của NVIDIA có thể sử dụng những “khối xây dựng” này và tùy chỉnh chúng bằng cách kết hợp các loại CPU, GPU và DPU khác nhau để tạo ra các cấu hình máy chủ đa dạng, phù hợp với từng khối lượng công việc riêng biệt.

Các đặc điểm nổi bật của nền tảng NVIDIA MGX

- Thiết kế mô-đun: Đây là điểm mấu chốt của MGX. Nó cho phép các nhà sản xuất máy chủ tái sử dụng thiết kế khung máy cơ bản và chỉ thay đổi các thành phần bên trong. Điều này giúp giảm đáng kể thời gian và chi phí phát triển.

- Tăng tốc thời gian đưa sản phẩm ra thị trường: Nhờ vào kiến trúc tham chiếu đã được tối ưu hóa, các đối tác có thể rút ngắn thời gian thiết kế và kiểm thử, từ đó nhanh chóng giới thiệu các máy chủ mới ra thị trường.

- Tính linh hoạt cao: MGX hỗ trợ nhiều loại phần cứng, bao gồm:

- CPU: Các CPU Grace của NVIDIA hoặc các CPU x86 từ Intel và AMD.

- GPU: Toàn bộ danh mục GPU của NVIDIA, từ các dòng H100 mạnh mẽ cho AI đến các GPU chuyên dụng khác.

- DPU: Các bộ xử lý dữ liệu BlueField của NVIDIA để tăng tốc mạng và bảo mật.

- Khung máy: Các kích thước tiêu chuẩn 1U, 2U, 4U với tùy chọn làm mát bằng khí hoặc chất lỏng.

- Tương thích đa thế hệ: Một lợi thế lớn của MGX là khả năng tương thích với các thế hệ phần cứng NVIDIA hiện tại và tương lai. Điều này cho phép các nhà sản xuất và khách hàng dễ dàng nâng cấp hệ thống mà không cần phải thay đổi toàn bộ cơ sở hạ tầng.

- Hỗ trợ phần mềm toàn diện: Các máy chủ dựa trên MGX được tích hợp đầy đủ với hệ sinh thái phần mềm của NVIDIA, bao gồm NVIDIA AI Enterprise và các bộ công cụ phát triển khác, giúp các doanh nghiệp dễ dàng triển khai các ứng dụng AI và HPC.

Những hãng nào cung cấp máy chủ dựa trên nền tảng NVIDIA MGX?

QCT và Supermicro là một trong số những hãng đầu tiên sử dụng đặc tả kỹ thuật máy chủ NVIDIA MGX, cho phép hơn 100 cấu hình hệ thống chuyên dụng cho việc tăng tốc các tải xử lý AI, HPC và Omniverse.

Để đáp ứng nhu cầu điện toán tăng tốc đa dạng của các trung tâm dữ liệu trên thế giới, NVIDIA đã công bố bảng đặc tả kỹ thuật của nền tảng máy chủ NVIDIA MGX từ sự kiện COMPUTEX năm 2023, cung cấp cho các nhà sản xuất hệ thống một kiến trúc tham chiếu module hóa để xây dựng hơn 100 biến thể máy chủ tăng tốc một cách nhanh chóng và tiết kiệm chi phí, phù hợp với dải nhu cầu đa dạng của AI, điện toán hiệu năng cao (HPC) và các ứng dụng Omniverse.

Supermicro, ASRock Rack, MSI, ASUS, GIGABYTE đã khai thác nền tảng MGX này để có thể cắt giảm tới 3/4 chi phí phát triển và giảm 2/3 thời gian phát triển xuống chỉ còn 6 tháng.

Với MGX, các nhà sản xuất có thể bắt đầu với kiến trúc hệ thống cơ bản được tối ưu hóa để tăng tốc điện toán cho bộ khung máy chủ của họ, sau đó chọn GPU, DPU và CPU. Các biến thể thiết kế có thể giải quyết các khối lượng công việc đặc thù, chẳng hạn như HPC, khoa học dữ liệu, mô hình ngôn ngữ lớn, điện toán biên, đồ họa và video, trí tuệ nhân tạo doanh nghiệp cũng như thiết kế và mô phỏng. Nhiều tác vụ như đào tạo AI và 5G có thể được xử lý trên một máy duy nhất, trong khi việc nâng cấp lên các thế hệ phần cứng trong tương lai có thể diễn ra suôn sẻ. MGX cũng có thể dễ dàng tích hợp vào các trung tâm dữ liệu doanh nghiệp và đám mây.

Hợp tác với các công ty dẫn đầu trong ngành

QCT và Supermicro sẽ là những nơi đầu tiên đưa ra thị trường các sản phẩm dựa trên MGX. Chẳng hạng như hệ thống ARS-221GL-NR của Supermicro bao gồm CPU NVIDIA Grace Superchip, trong khi hệ thống S74G-2U của QCT sử dụng NVIDIA GH200 Grace Hopper Superchip.

Ngoài ra, SoftBank Corp. có kế hoạch triển khai nhiều trung tâm dữ liệu hyperscale trên khắp Nhật Bản và sử dụng MGX để phân bổ động tài nguyên GPU giữa các ứng dụng Generative AI và 5G.

Junichi Miyakawa, Chủ tịch kiêm Giám đốc điều hành của SoftBank Corp cho biết: “Khi trí Generative AI tỏa khắp cộng đồng doanh nghiệp và người tiêu dùng, việc xây dựng hạ tầng phù hợp với chi phí hợp lý là một trong những thách thức lớn nhất của các nhà khai thác mạng. Nó cho phép triển khai AI đa mục đích, 5G, v.v. tùy thuộc vào yêu cầu của tải xử lý theo thời gian thực.”

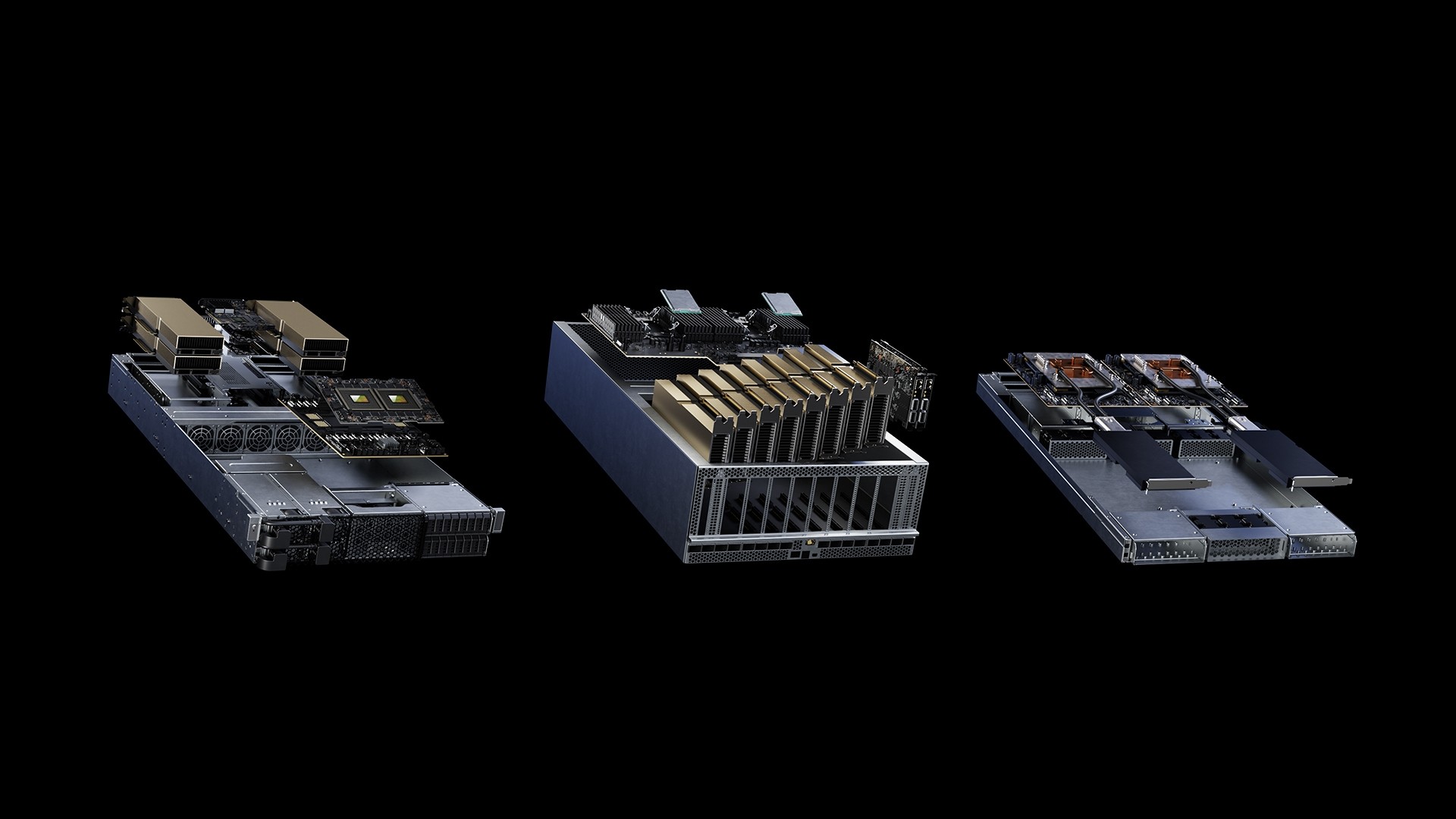

Các thiết kế khác nhau cho các nhu cầu khác nhau

Các trung tâm dữ liệu ngày càng cần đáp ứng các yêu cầu về cả khả năng tính toán ngày càng tăng và giảm lượng khí thải carbon để chống biến đổi khí hậu, đồng thời cắt giảm chi phí.

Các máy chủ điện toán tăng tốc của NVIDIA từ lâu đã cung cấp hiệu suất điện toán và hiệu suất năng lượng vượt trội. Giờ đây, thiết kế module hóa của MGX mang đến cho các nhà sản xuất hệ thống khả năng đáp ứng hiệu quả hơn các yêu cầu về ngân sách, cung cấp điện, thiết kế nhiệt và cơ học riêng của từng khách hàng.

Nhiều form factor mang lại tính linh hoạt tối đa

MGX hoạt động với các form factor khác nhau và tương thích với các thế hệ phần cứng NVIDIA hiện tại và tương lai, bao gồm:

- Chassis: 1U, 2U, 4U (làm mát bằng không khí hoặc chất lỏng)

- GPU: Danh mục GPU NVIDIA đầy đủ bao gồm H100, L40, L4 mới nhất

- CPU: NVIDIA Grace CPU Superchip, GH200 Grace Hopper Superchip, CPU x86

- Kết nối mạng: Bộ điều hợp mạng NVIDIA BlueField-3 DPU, ConnectX-7

MGX khác với NVIDIA HGX ở chỗ, nó cung cấp khả năng tương thích linh hoạt, hỗ trợ đa thế hệ với các sản phẩm của NVIDIA để đảm bảo các nhà sản xuất hệ thống có thể sử dụng lại các thiết kế hiện có và dễ dàng áp dụng các sản phẩm thế hệ tiếp theo mà không cần thiết kế lại một cách tốn kém. Ngược lại, HGX dựa trên bo mạch chủ multi-GPU, được kết nối với NVLink và được điều chỉnh theo quy mô để tạo ra hệ thống AI và HPC tối ưu.

Hỗ trợ đầy đủ với phần mềm của NVIDIA

Ngoài phần cứng, MGX được hỗ trợ bởi các software stack đầy đủ của NVIDIA, cho phép các nhà phát triển và doanh nghiệp xây dựng và tăng tốc AI, HPC và các ứng dụng khác. Chúng bao gồm NVIDIA AI Enterprise, NVIDIA AI platform software layer, có hơn 100 framework và model được đào tạo trước (pre-trained) và công cụ phát triển để tăng tốc AI, khoa học dữ liệu nhằm phát triển và triển khai AI cấp doanh nghiệp, được hỗ trợ đầy đủ.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale