NVLink là một công nghệ kết nối nội bộ (interconnect) siêu tốc dành cho các bộ xử lý GPU và CPU trong những hệ thống máy tính được tăng tốc, HPC, giúp việc khai thác các núi dữ liệu khổng lồ trở nên khả thi.

Điện toán tăng tốc (Accelerated Computing) – Công nghệ từng chỉ giới hạn ở các hệ thống máy tính hiệu suất cao trong các phòng thí nghiệm và nghiên cứu của chính phủ – nay đã trở nên phổ biến.

Các ngân hàng, nhà sản xuất ô tô, nhà máy, bệnh viện, nhà bán lẻ… đang ứng dụng các siêu máy tính AI để đương đầu với lượng dữ liệu khổng lồ và ngày càng gia tăng mà họ cần phải hiểu và xử lý chúng.

Những hệ thống mạnh mẽ và hiệu quả này thường được ví như những ‘siêu xa lộ điện toán’. Chúng mang dữ liệu và các phép xử lý đi qua các đường dẫn song song trên một hành trình chớp nhoáng để đạt được những kết quả hữu ích cuối cùng.

Các bộ xử lý GPU và CPU là các tài nguyên dọc đường đi và điểm liên kết của chúng là các kết nối tốc độ cao. Và một tiêu chuẩn vàng trong các kết nối siêu tốc dành cho điện toán tăng tốc chính là NVLink.

Vậy, NVLink là gì?

NVLink là một kết nối tốc độ cao dành cho các GPU và CPU được hình thành bởi một giao thức phần mềm mạnh mẽ, truyền trên các dây dẫn được in trên các bo mạch xử lý. Nó cho phép các bộ xử lý gửi và nhận dữ liệu từ các memory pool dùng chung với tốc độ cực nhanh.

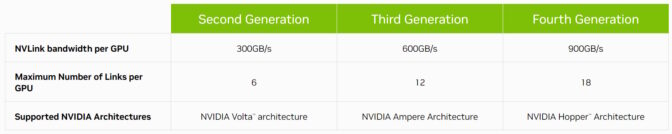

Hiện ở thế hệ thứ tư của nó, NVLink kết nối host và các bộ xử lý được tăng tốc với tốc độ lên tới 900GB/s.

Gấp hơn 7 lần băng thông của PCIe Gen 5, interconnect được sử dụng trong các máy chủ x86 thông thường. Và NVLink có hiệu quả năng lượng cao gấp 5 lần so với PCIe Gen 5, nhờ việc truyền dữ liệu chỉ tiêu thụ 1.3 picojoules mỗi bit.

Lịch sử của NVLink

Lần đầu tiên được giới thiệu như một kết nối nội bộ cho GPU NVIDIA P100. Từ đó, NVLink đã từng bước phát triển cùng với mỗi kiến trúc GPU mới hơn của NVIDIA.

Năm 2018, NVLink đã gây chú ý trong lĩnh vực điện toán hiệu năng cao (HPC) khi nó được giới thiệu với vai trò kết nối các GPU và CPU trong hai siêu máy tính mạnh mẽ nhất thế giới, Summit và Sierra.

Được lắp đặt tại Phòng thí nghiệm Quốc gia Oak Ridge và Lawrence Livermore, những hệ thống này đang dần mở rộng ranh giới của khoa học trong các lĩnh vực như nghiên cứu thuốc mới, dự đoán thảm họa thiên nhiên.

Băng thông tăng gấp đôi và chưa dừng lại

Năm 2020, NVLink thế hệ thứ ba đã tăng gấp đôi băng thông tối đa của nó trên mỗi GPU lên 600GB/s, đóng gói hàng tá kênh kết nối trong mỗi GPU NVIDIA A100 Tensor Core.

A100 hỗ trợ sức mạnh cho các siêu máy tính AI trong những trung tâm dữ liệu doanh nghiệp, dịch vụ điện toán đám mây và phòng thí nghiệm HPC trên toàn cầu.

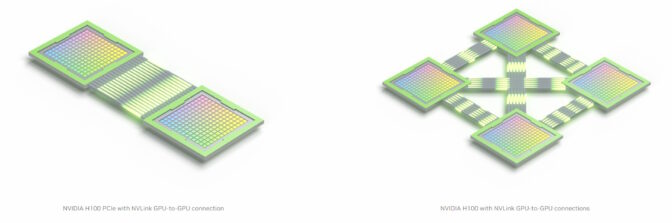

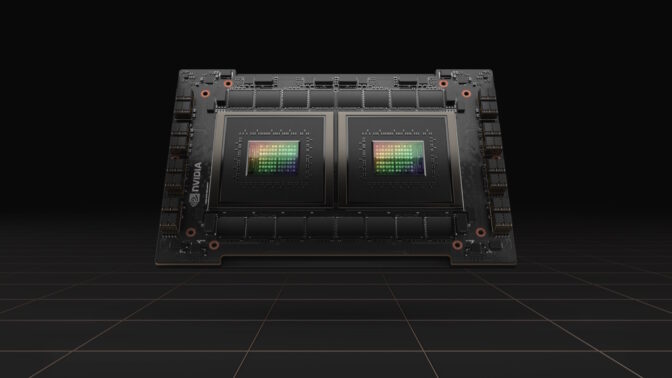

Hiện có 18 kênh kết nối NVLink thế hệ thứ tư được nhúng trong chỉ một GPU NVIDIA H100 Tensor Core. Và công nghệ này đã đảm nhận một vai trò chiến lược mới sẽ mang đến các CPU và các bộ tăng tốc tiên tiến nhất trên hành tinh.

Liên kết chip-to-chip

NVIDIA NVLink-C2C là một phiên bản kết nối nội bộ ở cấp độ bo mạch để kết hợp 2 vi xử lý bên trong một gói duy nhất, tạo nên một siêu chip. Ví dụ như nó kết nối hai chip để cung cấp 144 nhân Arm Neoverse V2 trong siêu chip NVIDIA Grace CPU, một vi xử lý được xây dựng để mang lại hiệu suất tiết kiệm năng lượng cho người dùng cloud, doanh nghiệp và HPC.

NVIDIA NVLink-C2C cũng kết hợp 1 CPU Grace và 1 GPU Hopper để tạo nên siêu chip Grace Hopper – thứ tích hợp điện toán tăng tốc dành cho các tải xử lý AI và HPC khó nhằn nhất trên thế giới vào trong một chip đơn lẻ.

Alps, một siêu máy tính AI được lên kế hoạch cho Swiss National Computing Center, sẽ là một trong những siêu máy tính đầu tiên sử dụng Grace Hopper. Khi ra mắt vào cuối năm nay, hệ thống hiệu suất cao này sẽ giải quyết các vấn đề khoa học lớn trong các lĩnh vực từ vật lý thiên văn đến hóa học lượng tử.

CPU Grace với 144 nhân Arm Neoverse V2 trên hai chip được kết nối bởi NVLink-C2C.

Grace và Grace Hopper cũng rất tuyệt vời trong việc mang lại hiệu quả năng lượng cho các workload điện toán đám mây đòi hỏi khắt khe.

Grace Hopper là một vi xử lý lý tưởng dành cho các hệ thống khuyến nghị (recommender systems). Những công cụ kinh tế này của Internet cần khả năng truy cập nhanh, hiệu quả vào nhiều dữ liệu để phục vụ hàng nghìn tỷ kết quả cho hàng tỷ người dùng mỗi ngày.

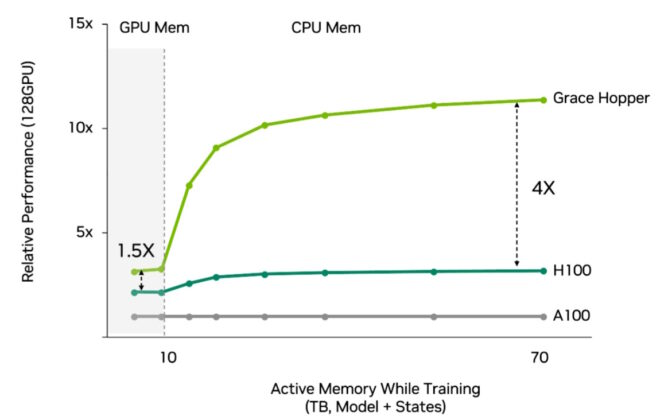

Các hệ thống khuyến nghị nhận được hiệu suất gấp 4 lần và hiệu quả cao hơn khi sử dụng Grace Hopper so với sử dụng Hopper với CPU truyền thống.

Ngoài ra, NVLink được sử dụng trong một system-on-chip mạnh mẽ dành cho các nhà sản xuất ô tô bao gồm các bộ xử lý NVIDIA Hopper, Grace và Ada Lovelace. NVIDIA DRIVE Thor là một máy tính trên xe hơi – hợp nhất các chức năng thông minh như digital instrument cluster, infotainment, lái và đỗ xe tự động vào trong một kiến trúc duy nhất.

Liên kết kiểu LEGO của hệ thống máy tính

NVLink cũng hoạt động giống như một socket được đóng vào một mảnh LEGO. Đó là cơ sở để xây dựng các siêu hệ thống nhằm giải quyết các công việc AI và HPC lớn nhất.

Ví dụ, các NVLink trên cả 8 GPU trong một hệ thống NVIDIA DGX chia sẻ các kết nối trực tiếp, nhanh chóng thông qua các chip NVSwitch. Chúng cùng nhau kích hoạt một mạng NVLink – nơi mỗi GPU trong máy chủ là một phần của một hệ thống đơn lẻ.

Để đạt được hiệu suất cao hơn nữa, bản thân các hệ thống DGX có thể được xếp chồng thành dạng modular gồm 32 máy chủ, tạo nên một cụm điện toán mạnh mẽ, hiệu quả.

NVLink là một trong những công nghệ then chốt cho phép người dùng dễ dàng mở rộng các hệ thống modular NVIDIA DGX thành cụm SuperPOD với hiệu suất AI lên đến cấp độ exaflop.

Người dùng có thể kết nối một khối modular gồm 32 hệ thống DGX thành một siêu máy tính AI duy nhất bằng việc sử dụng sự kết hợp một mạng NVLink bên trong DGX và NVIDIA Quantum-2 chuyển đổi kết cấu InfiniBand giữa chúng. NVIDIA DGX H100 SuperPOD đóng gói 256 GPU H100 để mang lại hiệu suất AI cao nhất lên đến cấp exaflop.

Để có được hiệu suất cao hơn nữa, người dùng có thể khai thác các siêu máy tính AI trên cloud, chẳng hạn như siêu máy tính mà Microsoft Azure đang xây dựng với hàng chục nghìn GPU A100 và H100. Nó là một dịch vụ được sử dụng bởi các nhóm phát triển như OpenAI để đào tạo một số mô hình generative AI lớn nhất trên thế giới.

Và đó là một ví dụ nữa về sức mạnh của điện toán tăng tốc.

Theo NVIDIA

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale