GPU NVIDIA A100 với Multi-Instance GPU – Mang đến nhiều GPU hơn cho bạn!

Hãy tưởng tượng bạn đang đứng ở siêu thị và trong giai đoạn đầu của đại dịch, chờ đợi ở phía sau một hàng dài với một xe đẩy đầy hàng nhu yếu phẩm phải mua và chỉ có một nhân viên thu ngân. Bạn đứng im lặng trong khi một số khác thì càu nhàu, có người bàn tán về những vấn đề nhỏ nhặt, ước gì họ có thêm nhân viên thu ngân để xử lý. Giờ hãy tưởng tượng có nhiều quầy thu ngân và quầy tự thanh toán hoạt động cùng lúc… Nói đến điều chắc bạn đã đủ hiểu vấn đề rồi phải không?

Đó là cốt lõi của MIG (Multi-Instance GPU) và được thiết kế trong kiến trúc NVIDIA Ampere.

MIG là gì?

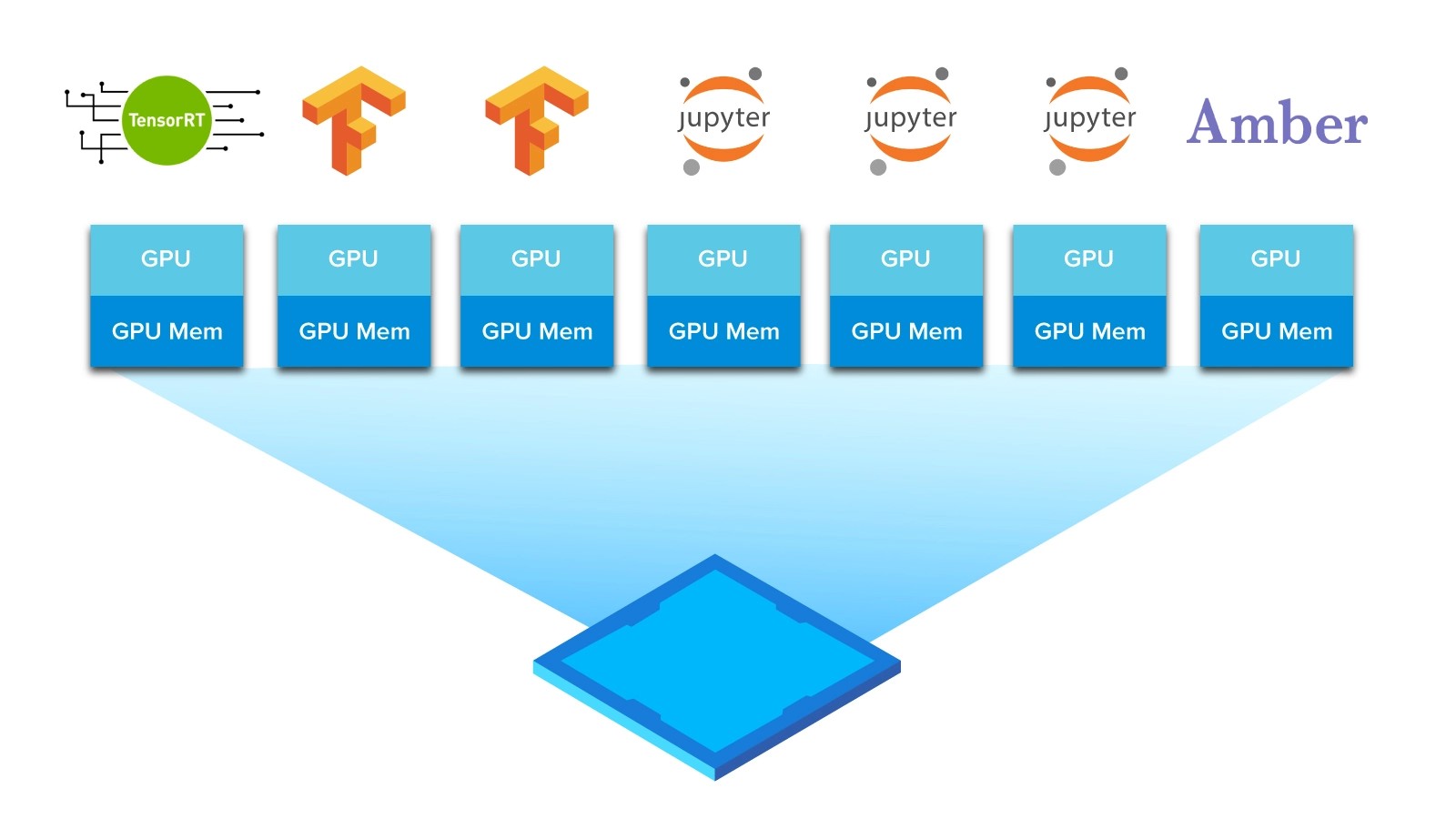

Multi-Instance GPU (MIG) mở rộng hiệu suất và giá trị của từng GPU NVIDIA A100 Tensor Core. MIG có thể phân chia một GPU NVIDIA A100 duy nhất thành bảy GPU ảo, mỗi GPU ảo được cô lập hoàn toàn với bộ nhớ băng thông cao, bộ nhớ cache và multiprocessors của riêng chúng. Điều đó cho phép GPU A100 cung cấp khả năng quality-of-service (QoS) đảm bảo cho mọi công việc, tối ưu hóa việc sử dụng và mở rộng phạm vi tiếp cận của các tài nguyên xử lý được tăng tốc cho mọi user với mức sử dụng cao hơn gấp 7 lần so với các GPU trước đây.

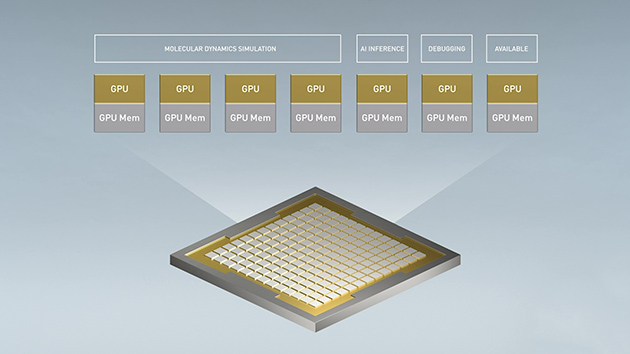

A100 ở chế độ MIG cung cấp sự linh hoạt để chọn nhiều kích thước GPU ảo khác nhau. Nó có thể chạy với bất kỳ sự kết hợp nào của tối đa bảy tải công việc HPC hoặc AI có kích thước khác nhau, cung cấp GPU ảo có kích thước phù hợp cho mỗi tải công việc. Điều này đặc biệt có lợi cho các tải công việc không sử dụng hết hoàn toàn khả năng xử lý của GPU, vì vậy bạn có thể muốn chạy các tải công việc khác nhau song song để tối đa hóa mức sử dụng.

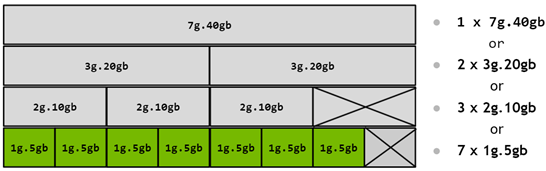

Ví dụ: người dùng có thể tạo ba đơn vị GPU ảo MIG với 10 gigabyte (GB) bộ nhớ mỗi đơn vị, hai cái với 20GB hoặc bảy cái với 5GB. Với MIG, người dùng tạo ra sự kết hợp phù hợp với tải công việc của họ.

GPU Instance so với Compute Instance

Khi bạn nghĩ về các GPU ảo / GPU Instance, hãy nghĩ chúng giống như việc cắt một GPU lớn thành nhiều GPU nhỏ hơn khác nhau, với mỗi GPU ảo có phân tách mức hardware, cùng các tài nguyên bộ nhớ và xử lý chuyên dụng. Tất cả được cô lập và bảo vệ khỏi ảnh hưởng của lỗi lẫn nhau (do các GPU ảo khác gây ra). Hoặc, hãy tưởng tượng toàn bộ GPU như một GPU ảo, có thể được chia thành tối đa bảy đơn vị GPU với MIG.

Ở góc độ khác, một Compute Instance có thể được cấu hình các mức hiệu năng xử lý khác nhau trong một GPU ảo. Một GPU ảo tiếp tục có thể được chia thành nhiều Compute Instance nhỏ hơn để tách biệt hơn nữa các tài nguyên xử lý của nó.

MIG Partitioning và GPU Instance profiles

MIG không cho phép tạo các GPU ảo với số lượng tùy ý. Thay vào đó, nó cung cấp một số thiết lập GPU ảo cố định (profiles) để bạn lựa chọn. Trên một GPU nhất định, bạn có thể tạo nhiều GPU ảo từ sự kết hợp của các profiles này với khả năng còn lại của các đơn vị GPU.

Được xây dựng cho nhà phát triển

Các nhà phát triển sẽ không phải thay đổi CUDA programming model của mình để có được những lợi ích của MIG. Đối với AI và HPC, MIG hoạt động với các hệ điều hành Linux hiện có cũng như Kubernetes và container. MIG cho phép một loạt các tải công việc được tăng tốc bởi AI mới chạy trên các nền tảng Red Hat, từ Cloud cho đến Edge.

MIG được kích hoạt bằng phần mềm được cung cấp cho NVIDIA A100. Nó bao gồm GPU driver, phần mềm CUDA 11 của NVIDIA, NVIDIA container runtime được cập nhật và loại tài nguyên mới trong Kubernetes thông qua NVIDIA Device Plugin. Với NVIDIA A100 và phần mềm của nó, các nhà phát triển sẽ có thể xem và lên lịch các jobs trên tất cả các GPU ảo như thể chúng là các GPU vật lý.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale