Công cụ hợp nhất quy trình làm việc OpenVINO

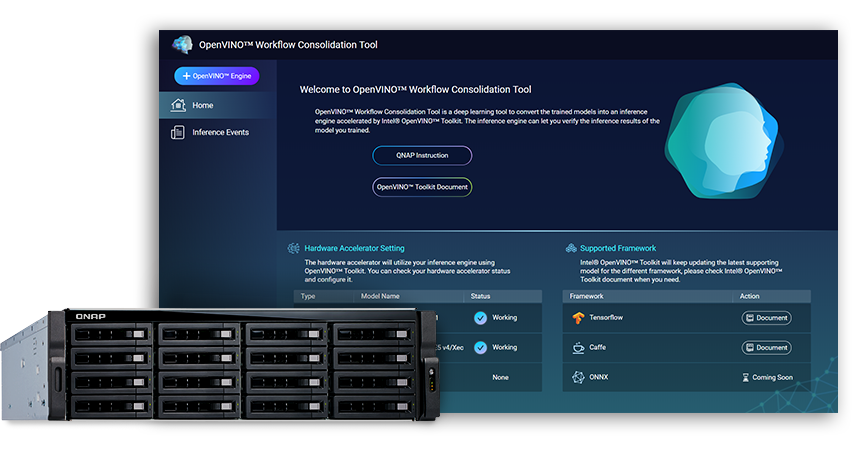

Công cụ hợp nhất quy trình làm việc OpenVINO (OpenVINO™ Workflow Consolidation Tool – OWCT), có sẵn từ QTS App Center, là một công cụ học tập sâu để chuyển đổi các mô hình được đào tạo thành dịch vụ suy luận được tăng tốc bởi Bộ công cụ phân phối OpenVINO™ của Intel® (Tối ưu hóa thị giác và tối ưu hóa mạng thần kinh) giúp phân phối một cách hiệu quả các giải pháp điện toán thị gián được thúc đẩy bởi AI.

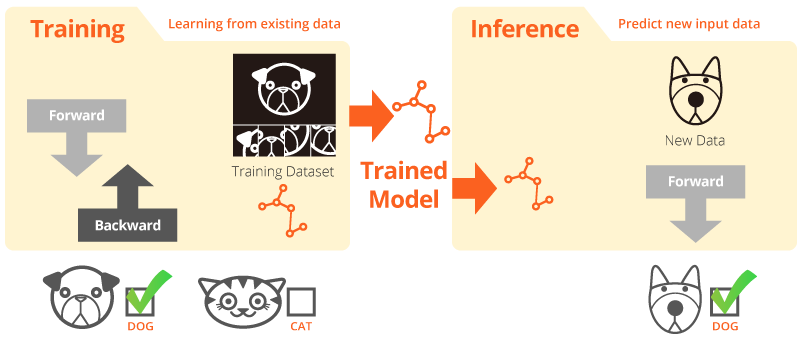

Đào tạo và suy luận

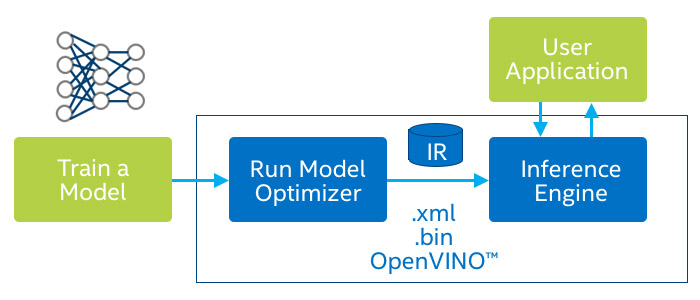

Đào tạo trực tuyến là khi hệ thống học hỏi từ dữ liệu hiện có. Thông tin suy luận là khi mô hình đã được đào tạo được sử dụng để đưa ra dự đoán hữu ích với dữ liệu trong thế giới thực.

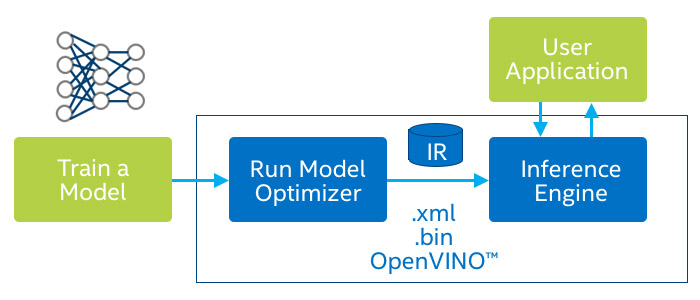

Bản phân phối Intel® của OpenVINO™ Toolkit

Bộ công cụ OpenVINO™ giúp đẩy nhanh quá trình phát triển điện toán thị giác hiệu năng cao và deep learning, biến chúng thành các ứng dụng thị giác. Nó cho phép triển khai deep learning trên các bộ tăng tốc bằng phần cứng và thực hiện không đồng nhất dễ dàng trên các nền tảng Intel®, bao gồm CPU, GPU, FPGA và VPU. Các thành phần chính bao gồm:

- Bộ công cụ triển khai Deep Learning của Intel® (Công cụ suy luận và tối ưu hóa model)

- Các chức năng được tối ưu hóa cho OpenCV * và OpenVX *

- Cung cấp hơn 15 mã mẫu và các mô hình được đào tạo trước để dễ dàng triển khai

Suy luận AI của bạn cho tầm nhìn máy tính, bây giờ trở nên nhanh hơn!

Những lợi ích chính của việc sử dụng Công cụ hợp nhất quy trình làm việc OpenVINO ™ (OWCT):

Tăng tốc

Bộ công cụ OpenVINO ™ chứa một thư viện nguồn mở giúp giảm thời gian phát triển và hợp lý hóa suy luận học tập sâu và triển khai các giải pháp định hướng tầm nhìn.

Tối ưu hóa

Trình tối ưu hóa mô hình chuyển đổi các mô hình được đào tạo thành biểu diễn trung gian (IR) và thực hiện tối ưu hóa cơ bản để suy luận hiệu quả.

GUI

OWCT sử dụng GUI cho phép người dùng dễ dàng sử dụng các khả năng của OpenVINO ™, hiển thị hình ảnh và tải xuống kết quả suy luận.

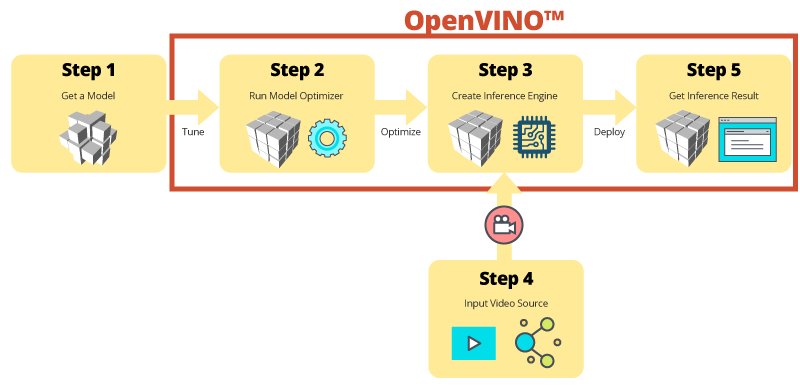

Suy luận từng bước với OWCT

OWCT hợp nhất tất cả các tính năng cần thiết của OpenVINO ™ để giúp bạn tạo Công cụ suy luận và xem xét kết quả suy luận của mô hình. Chỉ cần làm theo trình hướng dẫn ứng dụng và thiết lập mọi thứ chỉ trong vài bước!

Sử dụng các mô hình được đào tạo trước để thúc đẩy phát triển

Bên cạnh việc tìm kiếm hoặc đào tạo các mô hình của riêng bạn, bộ công cụ OpenVINO ™ cũng cung cấp các mô hình được đào tạo trước được tối ưu hóa của Intel® trong các ứng dụng người dùng, được gọi là Công cụ suy luận.

Sử dụng các mô hình được đào tạo trước

Bộ công cụ OpenVINO ™ bao gồm hai bộ mô hình được tối ưu hóa. Bạn có thể thêm các mô hình này trực tiếp vào môi trường của bạn và tăng tốc phát triển.

Mô hình được đào tạo trước:

- Nhận dạng độ tuổi & giới tính

- Ngã tư

- Xác định vị trí đầu

- Hàng rào an ninh

- Nhận dạng đặc điểm phương tiện

- … và hơn thế nữa

Sử dụng mô hình được đào tạo của bạn

Nhập các mô hình được đào tạo của riêng bạn để tận dụng tối ưu hóa từ Công cụ tối ưu hóa và suy luận mô hình, do đó, cuối cùng bạn có thể dễ dàng suy luận về tầm nhìn máy tính trên các kiến trúc Intel® hiện tại và trong tương lai để đáp ứng nhu cầu AI của bạn. Bộ công cụ OpenVINO ™ hoạt động với các mô hình được đào tạo trước sử dụng định dạng Caffe hoặc TensorFlow.

QNAP NAS là máy chủ suy luận

Bộ công cụ OpenVINO™ mở rộng khối lượng công việc trên phần cứng Intel® (bao gồm cả máy gia tốc) và tối đa hóa hiệu suất. Khi được sử dụng với Công cụ hợp nhất quy trình làm việc OpenVINO ™, QNAP NAS dựa trên Intel® trình bày một Máy chủ suy luận lý tưởng hỗ trợ các tổ chức nhanh chóng xây dựng một hệ thống suy luận. Cung cấp một công cụ tối ưu hóa và suy luận mô hình, bộ công cụ OpenVINO ™ rất dễ sử dụng và linh hoạt cho thị giác máy tính hiệu suất cao, độ trễ thấp giúp cải thiện suy luận học tập sâu. Các nhà phát triển AI có thể triển khai các mô hình được đào tạo trên NAS QNAP để suy luận và cài đặt các bộ tăng tốc phần cứng dựa trên nền tảng Intel® để đạt được hiệu suất tối ưu để chạy suy luận.

Công cụ suy luận dễ quản lý

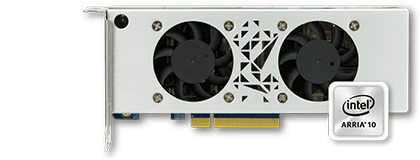

Cải thiện hiệu suất với accelerator card

Bộ công cụ OpenVINO™ hỗ trợ thực thi không đồng nhất trên các bộ tăng tốc thị giác máy tính (CPU, GPU, FPGA và VPU) bằng cách sử dụng API chung để tối ưu hóa cụ thể cho thiết bị.

-

Accelerator: Mustang-F100-A10

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Cấu hình thấp, kích thước một nửa, khe đôi

-

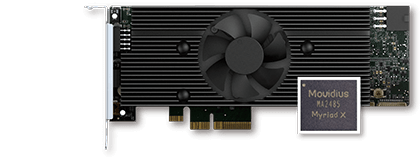

VPU Accelerator: Mustang-V100-MX8

- Giải pháp Intel® Movidius ™

- VPU My My ™ ™ X

- PCIe 2.0 x4

- Cấu hình thấp, kích thước một nửa, khe đơn

Chú thích:

- QTS 4.4.0 (hoặc mới hơn) và OWCT v1.1.0 được yêu cầu cho NAS QNAP.

- Để sử dụng tính toán thẻ đồ họa trên NAS QNAP, chức năng chuyển qua VM sẽ bị tắt. Để tránh mất dữ liệu tiềm ẩn, hãy đảm bảo rằng tất cả các tác vụ NAS đang diễn ra đã kết thúc trước khi khởi động lại.

- Hoàn thành các mô hình được hỗ trợ (Xem thêm OWCT Release Notes )

- TVS-x72XT: CPU, iGD, VPU (Lưu ý: TVS-472XT không được hỗ trợ)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU