Kiến trúc lưu trữ DDN A3I cho cụm Siêu máy tính AI NVIDIA DGX POD A100

DDN cung cấp nền tảng lưu trữ hiệu suất cao được tích hợp đầy đủ và tối ưu hóa đặc biệt cho hạ tầng điện toán tăng tốc AI, phân tích dữ liệu và HPC ở quy mô lớn.

1. DDN A3I hỗ trợ toàn diện cho NVIDIA DGX POD

Các giải pháp DDN A3I (Accelerated, Any-Scale AI) được thiết kế để đạt được hiệu quả cao nhất từ các ứng dụng AI, Phân tích dữ liệu và HPC quy mô lớn chạy trên hệ thống DGX và DGX POD. Chúng cung cấp hiệu suất, dung lượng và năng lực có thể dự báo được thông qua tích hợp chặt chẽ giữa hệ thống DDN và NVIDIA. Mọi lớp phần cứng và phần mềm tham gia vào việc cung cấp và lưu trữ dữ liệu đều được tối ưu hóa để truy cập, phản ứng nhanh nhạy và đáng tin cậy.

Các giải pháp DDN A3I được thiết kế, phát triển và tối ưu hóa với sự cộng tác chặt chẽ của NVIDIA.

Việc tích hợp sâu các thiết bị DDN AI với hệ thống DGX đảm bảo cho khách hàng có được trải nghiệm hoàn toàn tin cậy.

Các giải pháp DDN A3I có cấu hình cao để triển khai linh hoạt trong nhiều môi trường và mở rộng quy mô một cách liền mạch về dung lượng và khả năng để phù hợp với nhu cầu của các workload đang phát triển. Các giải pháp DDN A3I được triển khai trên toàn cầu và ở mọi quy mô, từ một hệ thống DGX duy nhất hoặc mở rộng đến cụm siêu máy tính NVIDIA DGX SuperPOD lớn nhất đang hoạt động hiện nay (NVIDIA DGX SuperPOD sẽ được giới thiệu trong phần sau).

Thiết bị lưu trữ DDN mang đến những công nghệ tiên tiến tương tự như đã được sử dụng để cung cấp sức mạnh cho các siêu máy tính lớn nhất thế giới trong một gói tích hợp hoàn chỉnh dành cho các hệ thống DGX dễ triển khai và quản lý. Các giải pháp DDN A3I đã được chứng minh là mang lại lợi ích tối đa cho khối lượng công việc AI, Analytics và HPC trên quy mô lớn trên các hệ thống DGX.

Phần này sẽ mô tả các tính năng nâng cao của Giải pháp DDN A3I cho DGX POD.

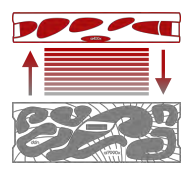

Kiến trúc song song dùng chung DDN A3I

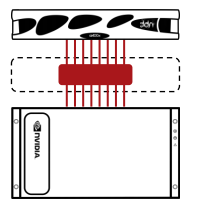

Kiến trúc song song được chia sẻ DDN A3I và client protocol đảm bảo mức hiệu suất, khả năng mở rộng, bảo mật và độ tin cậy cao cho các hệ thống DGX. Nhiều đường dữ liệu song song

mở rộng từ các ổ đĩa đến các ứng dụng được chạy trên GPU trong hệ thống DGX. Với tính năng song song end-to-end thực sự của DDN, dữ liệu được phân phối rất lớn với thông lượng cao, độ trễ thấp và đồng thời trong các giao dịch. Điều này đảm bảo các ứng dụng đạt được hiệu quả cao nhất từ hệ thống DGX với tất cả các chu kỳ GPU được đưa vào sử dụng một cách hiệu quả. Việc phân phối dữ liệu song song được tối ưu hóa trực tiếp giúp tăng hiệu suất ứng dụng và thời gian hoàn thành nhanh hơn.

Kiến trúc song song chia sẻ DDN A3I cũng chứa khả năng dự phòng và chuyển đổi dự phòng tự động để đảm bảo độ tin cậy cao, khả năng phục hồi và tính khả dụng của dữ liệu trong trường hợp kết nối mạng hoặc máy chủ gặp sự cố.

Hình ảnh mô tả kiến trức dữ liệu song song

Mạng đa tuyến DDN A3I

Các giải pháp DDN A3I tích hợp một loạt các công nghệ mạng và cấu trúc liên kết để đảm bảo triển khai hợp lý và hiệu suất tối ưu cho cơ sở hạ tầng AI. Thế hệ mới nhất InfiniBand (IB) và Ethernet cung cấp cả truyền dữ liệu băng thông cao và độ trễ thấp giữa các ứng dụng, máy chủ tính toán và thiết bị lưu trữ. Đối với DGX POD, DDN đề xuất Mạng IB với các thiết bị chuyển mạch mạng NVIDIA. DDN A3I Multirail đơn giản hóa đáng kể và tối ưu hóa mạng hệ thống DGX để có kết nối nhanh, an toàn và linh hoạt.

DDN A3I Multirail cho phép nhóm nhiều giao diện mạng trên hệ thống DGX để đạt được khả năng truyền dữ liệu tổng hợp nhanh hơn. Tính năng cân bằng lưu lượng truy cập động trên tất cả các giao diện và tích cực theo dõi tình trạng liên kết để phát hiện lỗi nhanh chóng và phục hồi tự động. DDN A3I Multirail giúp thiết kế, triển khai và quản lý mạng rất đơn giản và được chứng minh là cung cấp kết nối hoàn chỉnh cho cơ sở hạ tầng quy mô lớn để triển khai DGX POD.

Mô hình mạng đa tuyến

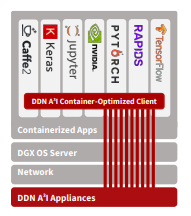

Vùng chứa ứng dụng DDN A3I

Vùng chứa đóng gói các ứng dụng và các thành phần của chúng để cung cấp khả năng thực thi đơn giản, đáng tin cậy và nhất quán. DDN cho phép kết nối trực tiếp hiệu suất cao giữa các vùng chứa ứng dụng trên hệ thống DGX A100 và hệ thống tập tin song song DDN. Điều này mang lại lợi ích đáng kể về hiệu suất ứng dụng bằng cách cho phép truy cập dữ liệu song song có độ trễ thấp, thông lượng cao trực tiếp từ một vùng chứa. Ngoài ra, các hạn chế của việc chia sẻ một kết nối cấp máy chủ duy nhất để lưu trữ giữa nhiều vùng chứa sẽ biến mất. Khả năng gắn kết hệ thống tập tin trong bộ chứa DDN được thêm vào trong thời gian chạy thông qua một trình bao bọc chung không yêu cầu bất kỳ sửa đổi nào đối với ứng dụng hoặc vùng chứa.

Các phiên bản container chứa các framework DL phổ biến được tối ưu hóa đặc biệt cho hệ thống DGX có sẵn từ NVIDIA. Chúng cung cấp một nền tảng vững chắc cho phép các nhà khoa học dữ liệu nhanh chóng

phát triển và triển khai các ứng dụng trên hệ thống DGX. Trong một số trường hợp, các phiên bản mã nguồn mở của container có sẵn, giúp các nhà phát triển có thể truy cập và tích hợp tốt hơn. Ứng dụng client container DDN A3I cung cấp khả năng truy cập dữ liệu song song hiệu suất cao trực tiếp từ các ứng dụng container trên hệ thống DGX. Điều này cung cấp cho các framework DL được chứa đựng với khả năng truy cập tập dữ liệu hiệu quả nhất có thể, loại bỏ tất cả các độ trễ do các lớp khác của ngăn xếp máy tính đưa vào.

Mô tả trực quan ứng dụng truy cập song song và trực tiếp đến thiết bị lưu trữ

DDN A3I Hot Pools

Hot Pools cung cấp cho người dùng khả năng di chuyển tự động các tập tin giữa cấp Flash (Hot Pool) sang cấp HDD (Cool Pool). Hot Pools được thiết kế cho các hoạt động quy mô lớn, quản lý các chuyển động dữ liệu nguyên bản và song song, hoàn toàn minh bạch với người dùng. Dựa trên công nghệ đồng bộ dữ liệu cấp độ tập tin đã được kiểm tra, Hot Pools cho phép các tổ chức tối ưu hóa chi phí – mở rộng dung lượng ổ cứng HDD và / hoặc các nhóm Flash disk một cách độc lập khi cần gia tăng dung lượng.

Mô tả sắp xếp dữ liệu giữa các nhóm đĩa lưu trữ Hot-Cool

2. Giải pháp DDN A3I với Hệ thống NVIDIA DGX A100

Kiến trúc có thể mở rộng DDN A3I tích hợp hệ thống DGX A100 với các thiết bị lưu trữ tập tin song song được chia sẻ DDN AI và cung cấp khả năng tăng tốc quy trình làm việc từ đầu đến cuối của AI, Analytics và HPC được tối ưu hóa hoàn toàn trên GPU. Các giải pháp DDN A3I giúp đơn giản hóa đáng kể việc triển khai hệ thống DGX A100 trong cụm cấu hình DGX POD, đồng thời mang lại hiệu suất và hiệu quả cho GPU tối đa và khả năng mở rộng ở mức độ cao.

Phần này mô tả các thành phần được tích hợp trong Giải pháp DDN A3I cho cụm DGX POD.

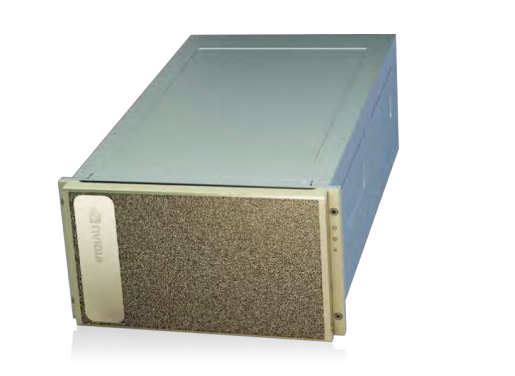

2.1 Thiết bị DDN AI400X

Thiết bị AI400X là một nền tảng dữ liệu được chia sẻ được tích hợp và tối ưu hóa hoàn toàn với dung lượng, khả năng cũng như hiệu suất. Mỗi thiết bị AI400X cung cấp trên 50GB/s và 3M IOPS trực tiếp tới hệ thống DGX A100 trong DGX POD. Hiệu suất được chia sẻ một cách tuyến tính khi các thiết bị AI400X bổ sung được tích hợp vào DGX POD. Cấu hình toàn bộ NVMe cung cấp hiệu suất tối ưu cho nhiều loại khối lượng công việc và dữ liệu khác nhau, đồng thời đảm bảo rằng các nhà khai thác DGX POD có thể đạt được nhiều nhất từ các ứng dụng GPU quy mô lớn, đồng thời duy trì một nền tảng dữ liệu tập trung, được chia sẻ và duy nhất. Thiết bị AI400X tích hợp kiến trúc song song DDN A3I và bao gồm nhiều khả năng được mô tả trong phần 1, bao gồm quản lý dữ liệu tự động, bảo mật kỹ thuật số và bảo vệ dữ liệu, cũng như giám sát toàn diện. Các thiết bị AI400X cho phép các nhà khai thác DGX POD có được một hệ thống vượt xa cơ sở hạ tầng cơ bản và triển khai các quy trình quản trị dữ liệu hoàn chỉnh trên quy mô lớn.

Thiết bị AI400X tích hợp với DGX POD qua IB, Ethernet và RoCE (RDMA-Remote direct memory access over Converged Ethernet ). Nó có sẵn trong các cấu hình dung lượng 32, 64, 128 và 256 TB cho tất cả NVMe. Các cấu hình kết hợp tùy chọn với ổ cứng tích hợp cũng có sẵn để triển khai yêu cầu lưu trữ dung lượng lớn mật độ cao.

Thiết bị lưu trữ DDN AI400X all-NVME

2.2 Hệ thống NVIDIA DGX A100

Hệ thống NVIDIA DGX A100 là hệ thống chung cho tất cả khối lượng công việc AI, cung cấp mật độ tính toán, hiệu suất và tính linh hoạt chưa từng có trong hệ thống AI 5 petaFLOPS đầu tiên trên thế giới. Được xây dựng dựa trên GPU NVIDIA A100 Tensor Core mang tính cách mạng, hệ thống DGX A100

hợp nhất cơ sở hạ tầng AI của trung tâm dữ liệu, chạy đồng thời khối lượng công việc đào tạo, suy luận và phân tích một cách dễ dàng. Hơn cả một máy chủ, hệ thống DGX A100 là khối xây dựng nền tảng của cơ sở hạ tầng AI và là một phần của giải pháp trung tâm dữ liệu đầu cuối NVIDIA được tạo ra từ hơn một thập kỷ tiên phong trong lĩnh vực AI của NVIDIA. Hệ thống DGX A100 tích hợp quyền truy cập độc quyền với đội ngũ chuyên gia thông thạo AI trên toàn cầu, từ việc lập kế hoạch, triển khai và chuyên môn tối ưu hóa để giúp khách hàng theo dõi nhanh quá trình chuyển đổi AI.

Hệ thống NVIDIA DGX A100

2.3 Chuyển mạch NVIDIA Mellanox

Bộ chuyển mạch mạng NVIDIA Mellanox cung cấp kết nối tối ưu cho DGX POD. DDN đề xuất công nghệ IB cho các mạng lưu trữ và tính toán chuyên sâu về dữ liệu trong DGX POD.

Switch IB NVIDIA Mellanox QM8700 HDR 200Gb/s cung cấp 40 cổng kết nối ở dạng 1U. Mỗi bộ chuyển mạch có khả năng lên đến 16Tb/s băng thông với độ trễ 130ns từ cổng này sang cổng khác. QM8700 là mô-đun lý tưởng để xây dựng kiến trúc các giải pháp có thể mở rộng với DGX POD mà không thể thay thế được.

Chuyển mạch NVIDIA Mellanox QM8700 HDR 200Gb/s InfiniBand

Đối với khách hàng yêu cầu kết nối Ethernet hoặc RoCE, bộ chuyển mạch NVIDIA Mellanox Spectrum SN3700 Open Ethernet cung cấp 32 cổng 200GbE trong một thân máy dạng 1U nhỏ gọn. Nó cho phép kết nối với các điểm cuối ở các tốc độ khác nhau và mang thông lượng 12,8Tb/s, với tốc độ cổng đầy đủ linh hoạt từ 10GbE đến 200GbE cho mỗi cổng. Điều này giúp đơn giản hóa việc tích hợp DGX POD trong bất kỳ môi trường Ethernet hiện có nào và đạt được hiệu suất tối ưu cho các mạng lưu trữ và tính toán dữ liệu chuyên sâu.

Chuyển mạch NVIDIA Mellanox Spectrum SN3700 Open Ethernet

Bộ chuyển mạch NVIDIA Mellanox AS4610 Data Center Open Ethernet là dòng thiết bị chuyển mạch Gigabit Ethernet Layer 3 có 54 cổng với 48 cổng 10/100 / 1000BASE-T, 4 x 10G SFP + cổng uplink. Nó cung cấp các khả năng mạnh mẽ cho lưu lượng truy cập cường độ thấp nhưng quan trọng như quản lý các thành phần trong DGX POD.

chuyển mạch NVIDIA Mellanox AS4610 Data Centre Open Ethernet

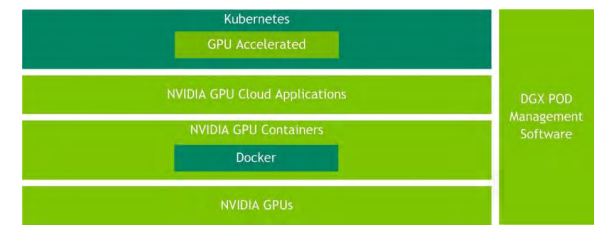

2.4 Phần mềm NVIDIA AI

Giá trị của kiến trúc DGX POD còn vượt xa phần cứng của nó. DGX POD là một hệ thống hoàn chỉnh cung cấp tất cả các thành phần chính để quản lý hệ thống, quản lý công việc và tối ưu hóa khối lượng công việc để đảm bảo triển khai nhanh chóng, dễ sử dụng và tính sẵn sàng cao (HA). Ngăn xếp phần mềm bắt đầu với Hệ điều hành DGX (DGX OS), được điều chỉnh và đủ điều kiện để sử dụng trên các hệ thống DGX A100. DGX POD chứa một bộ công cụ để quản lý việc triển khai, vận hành và giám sát cụm.

NVIDIA NGC ™ là thành phần chính của DGX POD, cung cấp các Framework DL mới nhất. NGC cung cấp các container được đóng gói, thử nghiệm và tối ưu hóa để triển khai nhanh chóng, dễ sử dụng và hiệu suất tốt nhất trên GPU NVIDIA. Cuối cùng, các công cụ chính như CUDA-X, Magnum IO và RAPIDS cung cấp cho các nhà phát triển các công cụ họ cần để tối đa hóa hiệu suất DL, HPC và khoa học dữ liệu trong môi trường đa cụm.

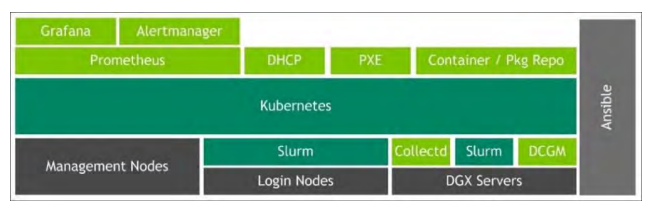

Hệ điều hành DGX và trình quản lý POD

Phần mềm NVIDIA AI (Hình bên dưới) chạy trên DGX POD cung cấp môi trường đào tạo DL hiệu suất cao cho các nhóm phát triển phần mềm AI đa người dùng quy mô lớn. Ngoài Hệ điều hành DGX, nó chứa trình quản lý cụm, công cụ điều phối và bộ lập lịch khối lượng công việc (phần mềm quản lý DGX POD), thư viện và Framework NVIDIA cũng như các vùng chứa được tối ưu hóa từ đăng ký trong NGC. Để có thêm chức năng, phần mềm quản lý DGX POD bao gồm các công cụ mã nguồn mở của bên thứ ba do NVIDIA đề xuất đã được thử nghiệm để hoạt động trên cụm DGX POD với ngăn xếp phần mềm NVIDIA AI. Hỗ trợ cho các công cụ này có sẵn trực tiếp từ các cấu trúc hỗ trợ của bên thứ ba.

NVIDIA AI Software

Nền tảng của phần mềm NVIDIA AI là DGX OS, được xây dựng trên phiên bản Ubuntu được tối ưu hóa. Đối với những khách hàng thích RedHat Linux, các gói phần mềm NVIDIA cần thiết để điều chỉnh

hệ điều hành dành riêng cho phần cứng DGX. Cho dù DGX OS hay RedHat, phần mềm DGX bao gồm trình điều khiển GPU được chứng nhận, ngăn xếp phần mềm mạng, bộ nhớ đệm cục bộ được định cấu hình trước, công cụ chẩn đoán quản lý GPU của trung tâm dữ liệu NVIDIA (DCGM) và GPU-enabled container runtime, tất cả đều được chứng nhận để hoạt động với NVIDIA NGC container.

Phần mềm quản lý DGX POD (Hình bên dưới) bao gồm các dịch vụ khác nhau chạy trên khung điều phối Kubernetes container để chịu lỗi và HA. Các dịch vụ được cung cấp cho cấu hình mạng (DHCP) và cung cấp phần mềm DGX OS hoàn toàn tự động qua mạng (PXE). Phần mềm DGX OS có thể được tự động cài đặt lại theo yêu cầu bằng phần mềm quản lý DGX POD.

Phần mềm quản lý NVIDIA DGX POD

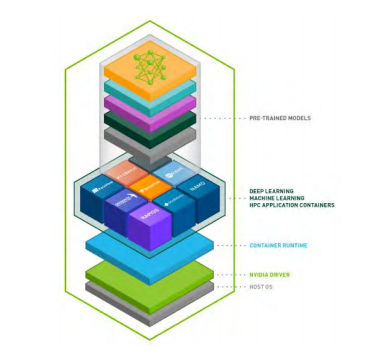

NVIDIA NGC

NVIDIA NGC (Hình bên dưới) cung cấp một loạt các tùy chọn đáp ứng nhu cầu của các nhà khoa học dữ liệu, nhà phát triển và nhà nghiên cứu với nhiều cấp độ chuyên môn khác nhau về AI. Những người dùng này có thể nhanh chóng triển khai các container chứa Framework AI, bắt đầu thuận lợi với các mô hình được đào tạo trước hoặc các tập lệnh đào tạo mô hình và sử dụng quy trình công việc cụ thể và biểu đồ Helm để triển khai AI nhanh nhất, cho họ thời gian giải quyết nhanh hơn.

NVIDIA NGC Software Stack

Mở rộng AI, khoa học dữ liệu và HPC, sổ đăng ký vùng chứa trên NGC có một loạt các phần mềm tăng tốc GPU cho GPU NVIDIA. NGC lưu trữ các vùng chứa cho AI và dữ liệu hàng đầu

phần mềm khoa học. Các container được điều chỉnh, thử nghiệm và tối ưu hóa bởi NVIDIA. Các container khác cho các ứng dụng HPC bổ sung và phân tích dữ liệu cũng được NVIDIA kiểm tra đầy đủ và cung cấp. NGC cung cấp phần mềm mạnh mẽ và dễ triển khai đã được chứng minh là mang lại kết quả nhanh nhất, cho phép người dùng xây dựng các giải pháp từ một framework đã được thử nghiệm, với sự kiểm soát hoàn toàn.

NGC cung cấp các hướng dẫn và tập lệnh từng bước để tạo các mô hình DL, với các chỉ số về hiệu suất và độ chính xác của mẫu để so sánh kết quả của bạn. Các tập lệnh này cung cấp hướng dẫn của chuyên gia về việc xây dựng các mô hình DL để phân loại hình ảnh, dịch ngôn ngữ, chuyển văn bản thành giọng nói và hơn thế nữa. Các nhà khoa học dữ liệu có thể nhanh chóng xây dựng các mô hình tối ưu hóa hiệu suất bằng cách dễ dàng điều chỉnh các siêu tham số. Ngoài ra, NGC cung cấp các mô hình được đào tạo trước cho nhiều tác vụ AI phổ biến được tối ưu hóa cho GPU NVIDIA Tensor Core và có thể dễ dàng đào tạo lại bằng cách cập nhật chỉ một vài lớp, tiết kiệm thời gian quý báu.

3. Kiến trúc tham chiếu DDN A3I cho DGX POD

DDN đề xuất các kiến trúc tham chiếu sau cho các cấu hình DGX POD đa nút. DDN A3I đã được xác thực đầy đủ với NVIDIA và đã được triển khai với một số khách hàng DGX POD trên toàn thế giới.

Thiết bị DDN AI400X là thiết bị chìa khóa trao tay để triển khai DGX quy mô lớn. DDN đề xuất thiết bị AI400X làm nền tảng dữ liệu tối ưu cho các thiết kế DGX POD với hệ thống DGX A100. Các thiết bị AI400X mang lại hiệu suất GPU tối ưu cho mọi khối lượng công việc và loại dữ liệu trong một khung 2U dày đặc, tiết kiệm điện. Thiết bị AI400X đơn giản hóa thiết kế, triển khai và quản lý DGX POD và cung cấp hiệu suất, dung lượng và khả năng mở rộng. Thiết bị AI400X được định cấu hình đầy đủ, sẵn sàng triển khai và cài đặt nhanh chóng. Thiết bị được thiết kế để tích hợp liền mạch với các hệ thống DGX và cho phép khách hàng chuyển nhanh chóng từ thử nghiệm sang sản xuất. Đồng thời, DDN cung cấp các dịch vụ thiết kế, triển khai và hỗ trợ chuyên gia hoàn chỉnh trên toàn cầu. Tổ chức kỹ thuật hiện trường DDN đã triển khai hàng chục giải pháp cho khách hàng dựa trên kiến trúc tham chiếu A3I.

Theo hướng dẫn chung, DDN khuyến nghị một thiết bị AI400X cho mỗi bốn hệ thống DGX A100 trong một DGX POD (Hình bên dưới). Các cấu hình này có thể được điều chỉnh và thay đổi tỷ lệ dễ dàng để phù hợp

yêu cầu khối lượng công việc cụ thể. Đối với mạng lưu trữ, DDN đề xuất công nghệ HDR200 trong cấu trúc liên kết mạng không chặn, với khả năng dự phòng để đảm bảo dữ liệu sẵn có. DDN khuyến nghị sử dụng ít nhất hai kết nối HDR200 cho mỗi hệ thống DGX A100 vào mạng lưu trữ

Hình minh họa tủ rack cho các cấu hình tham chiếu DDN A3I POD (không liệt kê thiết bị mạng)

3.1 Kiến trúc mạng DGX POD

Thiết kế tham chiếu DGX POD bao gồm bốn mạng:

Mạng lưu trữ: Cung cấp truyền dữ liệu giữa thiết bị AI400X và các nút máy tính. Kết nối tám cổng từ mỗi thiết bị AI400X. Kết nối hai cổng từ mỗi hệ thống DGX A100, mỗi hệ thống từ hai cổng NVIDIA Mellanox ConnectX®-6 HCA. Chúng có thể được cấu hình ở chế độ IB hoặc Ethernet. DDN khuyến nghị để đạt hiệu suất và hiệu quả tối ưu.

Mạng compute: Cung cấp giao tiếp giữa các nút DGX A100. Kết nối tám cổng đơn ConnectX-6 HCA từ mỗi hệ thống DGX A100. Chúng có thể được cấu hình ở chế độ IB InfiniBand hoặc Ethernet.

Mạng quản lý: Cung cấp quản lý và giám sát cho tất cả các thành phần DGX POD.

Kết nối cổng Quản lý 1 GbE RJ45 và 1 cổng GbE RJ45 BMC từ mỗi hệ thống DGX A100 và mỗi bộ điều khiển thiết bị AI400X với bộ chuyển mạch Ethernet.

Mạng cụm cluster (Tùy chọn): Cung cấp khả năng cung cấp và lập lịch công việc. Sử dụng cổng QSFP56 100 GbE trên mỗi hệ thống DGX A100 và các máy chủ bên ngoài (tùy chọn). Tổng quan về kiến trúc mạng DGX POD được thể hiện trong Hình 1, các kết nối mạng được khuyến nghị cho từng hệ thống DGX A100 trên Hình 2 và các kết nối mạng được khuyến nghị cho từng thiết bị DDN AI400X trên Hình 3.

Hình 1: Tổng quan về kiến trúc mạng DGX POD.

Kết nối mạng hệ thống DGX A100

Đối với DGX POD, DDN khuyến nghị các cổng từ 1 đến 8 trên hệ thống DGX A100 được kết nối với mạng compute. DDN khuyến nghị rằng tất cả các hệ thống DGX A100 trong DGX POD đều được trang bị với thẻ HCA tùy chọn. cổng 9 và 11 được kết nối với mạng lưu trữ. Đối với hệ thống DGX A100 không có thẻ HCA tùy chọn được lắp đặt, DDN khuyến nghị kết nối cổng 9 và 10 với mạng lưu trữ. Ngoài ra, các cổng quản lý (“M”) và BMC (“B”) phải được kết nối với mạng quản lý.

Hình 2 : Các kết nối cổng mạng hệ thống DGX A100 được đề xuất

Kết nối mạng thiết bị AI400X

Đối với DGX POD, DDN khuyến nghị kết nối các cổng từ 1 đến 8 trên thiết bị AI400X với mạng lưu trữ. Ngoài ra, các cổng quản lý (“M”) và BMC (“B”) cho cả hai bộ điều khiển nên được kết nối với mạng quản lý. Lưu ý rằng mỗi thiết bị AI400X yêu cầu hai kết nối cổng mạng giữa bộ điều khiển (“I1” và “I2”) bằng cách sử dụng cáp ethernet ngắn được cung cấp kèm theo.

hình 3 :Các kết nối cổng mạng của thiết bị AI400X được đề xuất.

3.2 DGX POD với hai hệ thống DGX A100

Hình bên dưới minh họa kiến trúc DDN A3I trong cấu hình 1:2 trong đó hai hệ thống DGX A100 được kết nối với thiết bị AI400X thông qua một cặp Switch mạng được cấu hình cho HA. Mọi hệ thống DGX A100 kết nối với mỗi mạng lưu trữ sẽ chuyển qua một liên kết HDR hoặc 100GbE. Thiết bị AI400X kết nối với từng Switch mạng lưu trữ thông qua bốn liên kết HDR 200Gb/s IB hoặc 100GbE. Các thiết bị chuyển mạch mạng lưu trữ là kết nối với nhau bằng bốn liên kết chuyên dụng. Điều này đảm bảo giao tiếp dữ liệu không bị chặn giữa mọi thiết bị được kết nối với mạng.Thiết kế HA cung cấp khả năng dự phòng đầy đủ và dữ liệu sẵn có tối đa trong trường hợp thành phần bị lỗi ở một trong các thiết bị.

Kiến trúc tham chiếu DDN A3I POD với hai hệ thống DGX A100 (không hiển thị mạng quản lý).

Sơ đồ mạng DDN A3I POD với hai hệ thống DGX A100.

3.3 DGX POD với bốn hệ thống DGX A100

Hình bên dưới minh họa kiến trúc DDN A3I trong cấu hình 1:4, trong đó bốn hệ thống DGX A100 được kết nối với một thiết bị AI400X thông qua một cặp Switch mạng được cấu hình cho HA. Mọi hệ thống DGX A100 kết nối với mỗi mạng lưu trữ sẽ chuyển qua một liên kết HDR 200Gb/s IB hoặc 100GbE. Thiết bị AI400X kết nối với từng Switch mạng lưu trữ thông qua bốn liên kết HDR 200Gb/s IB hoặc 100GbE. Các thiết bị chuyển mạch mạng lưu trữ được kết nối với nhau bằng bốn liên kết chuyên dụng. Điều này đảm bảo giao tiếp dữ liệu không bị chặn giữa mọi thiết bị được kết nối với mạng. Thiết kế HA cung cấp khả năng dự phòng đầy đủ và dữ liệu sẵn có tối đa trong trường hợp thành phần bị lỗi ở một trong các thiết bị.

Kiến trúc tham chiếu DDN A3I POD với bốn hệ thống DGX A100 (không hiển thị mạng quản lý)

Sơ đồ mạng DDN A3I POD với bốn hệ thống DGX A100

3.4 DGX POD với tám hệ thống DGX A100

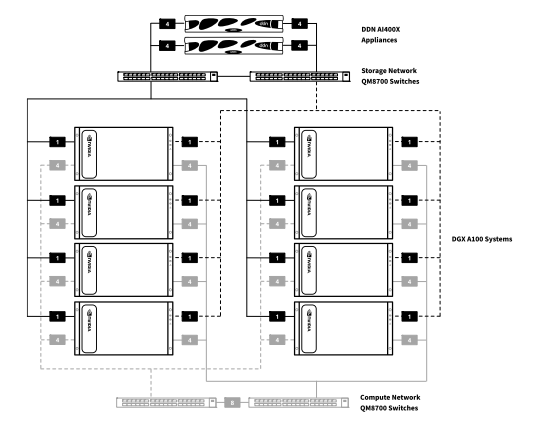

Hình bên dưới minh họa kiến trúc DDN A3I trong cấu hình 2:8 trong đó tám hệ thống DGX A100 được kết nối với hai thiết bị AI400X thông qua một cặp chuyển mạch mạng được cấu hình cho HA. Mọi hệ thống DGX A100 kết nối với mỗi mạng lưu trữ sẽ chuyển qua một liên kết HDR 200Gb/s IB hoặc 100GbE. Thiết bị AI400X kết nối với từng switch mạng lưu trữ thông qua bốn liên kết HDR 200Gb/s IB hoặc 100GbE. Các thiết bị chuyển mạch mạng lưu trữ được kết nối với nhau qua tám liên kết chuyên dụng. Điều này đảm bảo giao tiếp dữ liệu không bị chặn giữa mọi thiết bị được kết nối với mạng. Thiết kế HA cung cấp khả năng dự phòng đầy đủ và dữ liệu sẵn có tối đa trong trường hợp thành phần bị lỗi ở một trong các thiết bị.

Kiến trúc tham chiếu DDN A3I POD với tám hệ thống DGX A100 (không hiển thị mạng quản lý).

Sơ đồ mạng DDN A3I POD với tám hệ thống DGX A100 (A-D). (E-H)

3.5 Máy chủ quản lý tùy chọn

Thiết kế tham chiếu DGX POD bao gồm ba máy chủ tùy chọn để quản lý cụm nâng cao như cung cấp tài nguyên và lập lịch công việc. Các máy chủ tích hợp liền mạch với Kiến trúc tham chiếu DDN A3I cho DGX POD với hai, bốn và tám cấu hình hệ thống DGX A100. Các máy chủ kết nối với cùng một mạng lưu trữ và quản lý như hệ thống DGX A100 và thiết bị AI400X. Điều này cho phép truy cập trực tiếp vào phần được chia sẻ hệ thống tập tin từ máy chủ và cũng cung cấp kết nối với hệ thống DGX A100 cho các hoạt động cụm. Đối với các cấu hình DGX POD yêu cầu cụm thông lượng rất cao để quản lý, một mạng 100GbE chuyên dụng có thể được triển khai để kết nối hệ thống DGX A100 với các máy chủ. NVIDIA hiện xác nhận các thiết kế sử dụng mạng chuyên dụng 100 GbE.

Vui lòng liên hệ với bộ phận giải pháp của Nhất Tiến Chung để thảo luận về các cấu hình máy chủ tùy chọn và đảm bảo đạt được sự tối ưu cho cả cơ sở hạ tầng và ứng dụng.

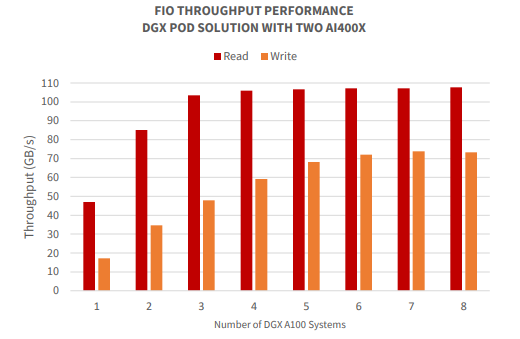

4. Giải pháp DDN A3I với Xác thực NVIDIA DGX POD

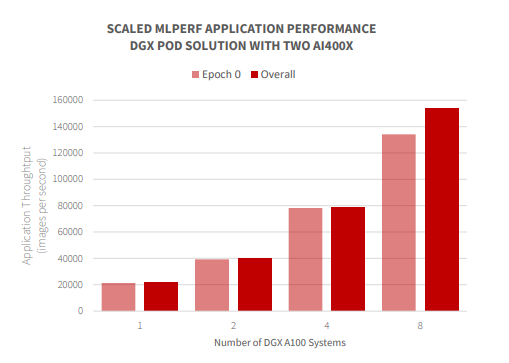

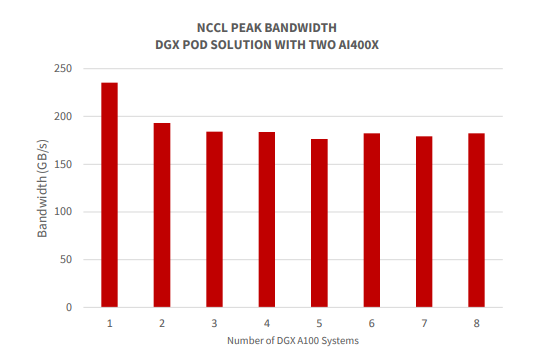

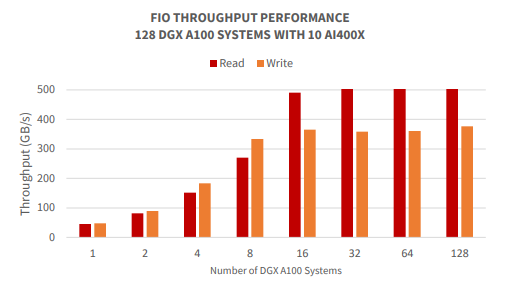

DDN thực hiện các nỗ lực tích hợp, tối ưu hóa và xác thực kỹ thuật rộng rãi với sự cộng tác chặt chẽ với NVIDIA để đảm bảo trải nghiệm người dùng cuối tốt nhất có thể bằng cách sử dụng các thiết kế tham chiếu trong tài liệu này. Việc cùng xác nhận tích hợp chức năng và hiệu suất tối ưu cho các cấu hình DGX POD. Kiểm tra hiệu suất trên kiến trúc DDN A3I được tiến hành với các ứng dụng IOPS và thông lượng tổng hợp tiêu chuẩn công nghiệp, cũng như các kiểu dữ liệu và framework DL được sử dụng rộng rãi. Kết quả chứng minh rằng với kiến trúc song song được chia sẻ DDN A3I, các ứng dụng được container hóa có thể sử dụng toàn bộ khả năng của cơ sở hạ tầng dữ liệu và hệ thống DGX A100. Hiệu suất được phân bổ đồng đều trên tất cả các hệ thống DGX A100 trong DGX POD và chia tỷ lệ tuyến tính khi có nhiều hệ thống DGX A100 hơn. Phần này trình bày chi tiết một số kết quả từ thử nghiệm quy mô gần đây tích hợp thiết bị AI400X với tối đa tám hệ thống DGX A100.

Các thử nghiệm được mô tả trong phần này được thực hiện trong trung tâm dữ liệu NVIDIA trên tám hệ thống DGX A100 được trang bị tám GPU A100 chạy Phần mềm máy chủ hệ điều hành DGX 4.99.11 và hai thiết bị AI400X đang chạy DDN EXAScaler v5.2.2.

Đối với mạng lưu trữ, tất cả tám hệ thống DGX A100 được kết nối với Switch Mellanox QM8700 với hai liên kết HDR 200Gb/s IB, một liên kết cho mỗi bộ chuyển đổi cổng kép (xem khuyến nghị trong phần 3.1). AI400X được kết nối với cùng một mạng với tám liên kết HDR100 IB mỗi cổng.

Switch đang chạy Mellanox OS 3.9.0606. Đối với mạng tính toán, tất cả tám hệ thống DGX A100 đều được kết nối với mạng IB HDR 200Gb/s không chặn. Tất cả tám cổng đơn mạng trên hệ thống DGX A100 được kết nối với mạng tính toán compute.

Môi trường thử nghiệm này cho phép chúng tôi chứng minh hiệu suất với cấu hình DGX POD lớn nhất có thể.

Môi trường thử nghiệm với hệ thống tám DGX A100 và hai AI400X (không hiển thị mạng quản lý)

Thông lượng FIO với cấu hình DGX POD được chia tỷ lệ.

Thông lượng ứng dụng ML Perf với cấu hình DGX POD được chia tỷ lệ.

Băng thông NCCL với cấu hình DGX POD được chia tỷ lệ.

Mở rộng thông lượng FIO với một số lượng rất lớn các hệ thống DGX A100.

5. Lời kết

DDN từ lâu đã trở thành đối tác được lựa chọn cho các tổ chức theo đuổi các dự án theo hướng dữ liệu quy mô lớn. Ngoài các nền tảng công nghệ với khả năng đã được kiểm chứng, DDN cung cấp kỹ thuật chuyên môn sâu thông qua các nghiên cứu và phát triển toàn cầu, cùng các tổ chức kỹ thuật tại hiện trường.

Một đội ngũ toàn cầu với hàng trăm kỹ sư và chuyên gia kỹ thuật có thể được kêu gọi để

tối ưu hóa mọi giai đoạn của dự án khách hàng: khởi đầu ban đầu, kiến trúc giải pháp, hệ thống

triển khai, hỗ trợ khách hàng và nhu cầu mở rộng quy mô trong tương lai.

Tập trung vào khách hàng mạnh mẽ cùng với sự xuất sắc về kỹ thuật và kinh nghiệm chuyên sâu đảm bảo DDN cung cấp giải pháp tốt nhất có thể cho bất kỳ thách thức nào. Thực hiện phương pháp tham vấn, các chuyên gia DDN sẽ thực hiện đánh giá chuyên sâu các yêu cầu và đưa ra mức ứng dụng tối ưu hóa quy trình làm việc dữ liệu cho một dự án. Sau đó, họ sẽ thiết kế và đề xuất một giải pháp có độ tin cậy cao và dễ sử dụng cho phép tốt nhất và tăng tốc nỗ lực của khách hàng.

Rút ra từ lịch sử phong phú của công ty trong việc triển khai thành công các dự án quy mô lớn, các chuyên gia của DDN sẽ tạo ra một chương trình có cấu trúc để xác định và thực thi một giao thức thử nghiệm phản ánh môi trường khách hàng để đáp ứng và vượt quá các mục tiêu của dự án. DDN đã trang bị các phòng thí nghiệm với nền tảng tính toán GPU hàng đầu để cung cấp điểm benchmark duy nhất và khả năng thử nghiệm cho các ứng dụng AI và DL.

Giới thiệu về DDN

DataDirect Networks (DDN) là nhà cung cấp lưu trữ dữ liệu lớn hàng đầu thế giới cho các tổ chức toàn cầu, chuyên sâu về dữ liệu. DDN đã thiết kế, phát triển, triển khai và tối ưu hóa các hệ thống, phần mềm và giải pháp cho phép các doanh nghiệp, nhà cung cấp dịch vụ, cơ sở nghiên cứu và các cơ quan chính phủ tạo ra nhiều giá trị hơn và đẩy nhanh thời gian để hiểu rõ hơn từ dữ liệu và thông tin của họ, tại chỗ và đám mây.

Nhất Tiến Chung (NTC) là nhà cung cấp các giải pháp hạ tầng CNTT, Điện toán Hiệu năng cao (HPC) cho AI, phân tích Big Data và Visual Computing, với kinh nghiệm kinh doanh phần cứng từ năm 2005. NTC chính thức trở thành nhà cung cấp giải pháp lưu trữ hiệu năng cao, nền tảng lưu trữ song song của DDN từ năm 2021.