NLP và LLM là gì?

Xử lý ngôn ngữ tự nhiên (NLP) là một nhánh của Trí tuệ nhân tạo (AI) cho phép máy móc hiểu và diễn giải ngôn ngữ của con người. Những tiến bộ gần đây trong Học sâu đã dẫn đến sự xuất hiện của các Mô hình ngôn ngữ lớn (LLM), thể hiện khả năng hiểu ngôn ngữ tự nhiên đến kỳ lạ, đã cách mạng hóa thế giới và có tác động đáng kể đến tương lai. Các công ty và các startup đã chọn đào tạo những LLM này trên phần cứng chuyên dụng của NVIDIA: DGX.

Mô hình ngôn ngữ lớn (LLM) là một loại Mô hình ngôn ngữ bao gồm một mạng nơ-ron nhân tạo (neural network) của các tham số được đào tạo trên một lượng lớn dữ liệu văn bản chưa được gắn nhãn. LLM nổi tiếng nhất là series GPT (Generative Pre-trained Transformer) của OpenAI, được đào tạo trên hàng tỷ từ, là nền tảng dành cho ChatGPT.

Các ứng dụng khác nhau sử dụng GPT làm nền tảng để xây dựng các chatbot, trình tóm tắt cực kỳ thuyết phục,… Các LLM đã thể hiện hiệu suất vượt trội trong một loạt các tác vụ NLP như dịch ngôn ngữ, trả lời câu hỏi và tạo văn bản. ChatGPT (được đào tạo ban đầu trên GPT-3) và ChatGPT Plus (được đào tạo trên GPT-4) đã tạo nên những làn sóng to lớn trong việc đưa AI đến với công chúng và người tiêu dùng.

Việc cho phép máy tính tương tác với thế giới vật chất của chúng ta đã trở thành hiện thực. Các LLM có nhiều ứng dụng trong các ngành khác nhau như chatbot được cá nhân hóa, tự động hóa dịch vụ khách hàng, phân tích cảm xúc và tạo nội dung hoặc thậm chí là mã lập trình. Vậy tại sao các tổ chức quy mô lớn này lại chọn NVIDIA DGX? Sự khác biệt giữa DGX và các GPU PCIe truyền thống là gì?

NVIDIA DGX/HGX và SXM Form Factor GPU

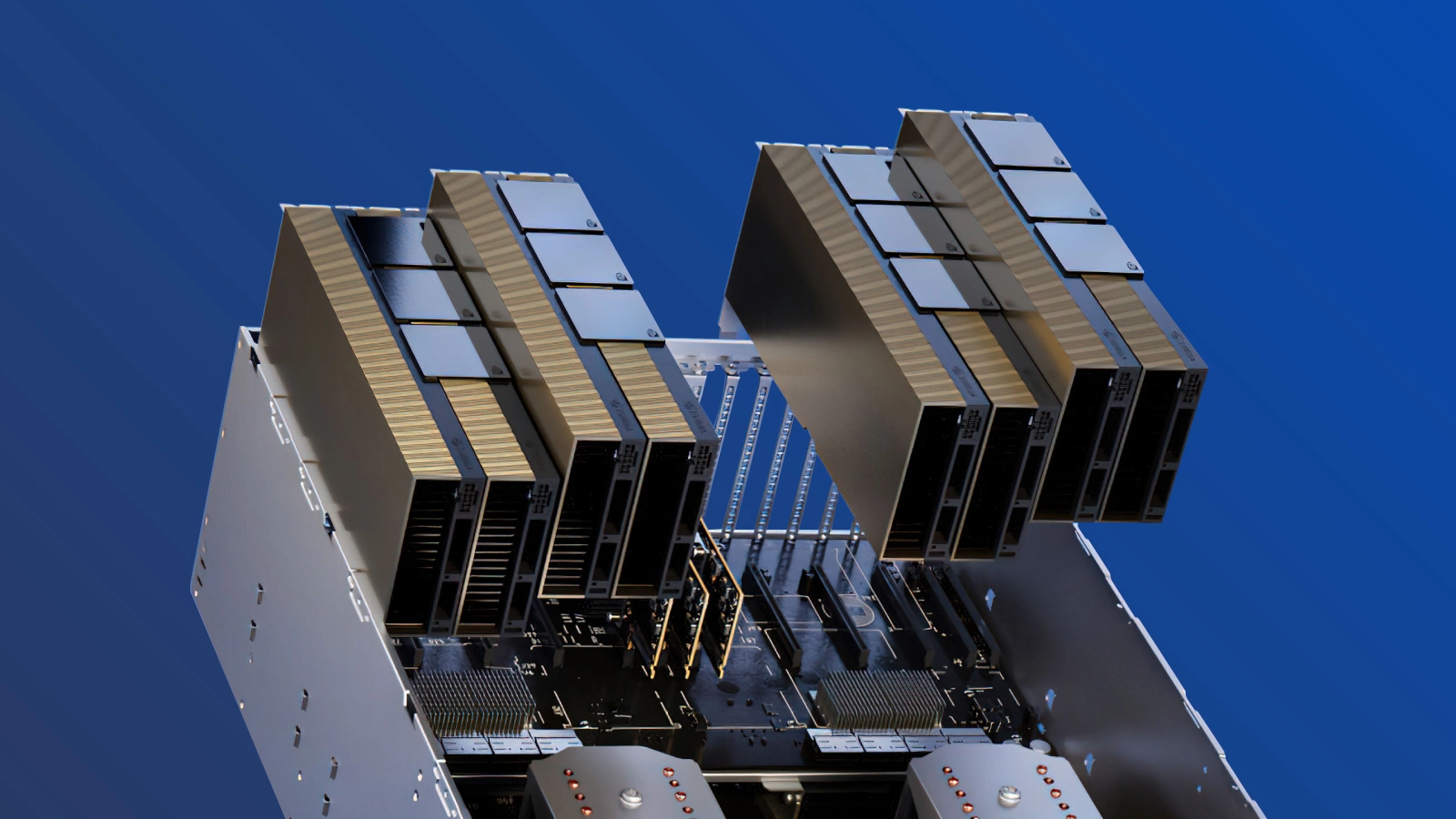

Kiến trúc SXM là một giải pháp socketed băng thông cao để kết nối những bộ tăng tốc NVIDIA Tensor Core với hệ thống DGX và HGX độc quyền của họ. Đối với mỗi thế hệ GPU NVIDIA Tensor Core (P100, V100, A100 và hiện tại là H100), các bo mạch HGX của hệ thống DGX đi kèm với loại socket SXM mang đến băng thông cao, khả năng cung cấp năng lượng và nhiều hơn nữa đối với các card GPU phù hợp của chúng.

Các bo mạch hệ thống HGX chuyên dụng kết nối nội bộ (interconnect) 8 GPU thông qua NVLink, cung cấp băng thông cao giữa các GPU. Những khả năng của NVLink truyền dữ liệu giữa các GPU cực kỳ nhanh, cho phép chúng hoạt động như một GPU đơn mạnh mẽ, trao đổi dữ liệu mà không cần chuyển qua PCIe hoặc cần giao tiếp với CPU.

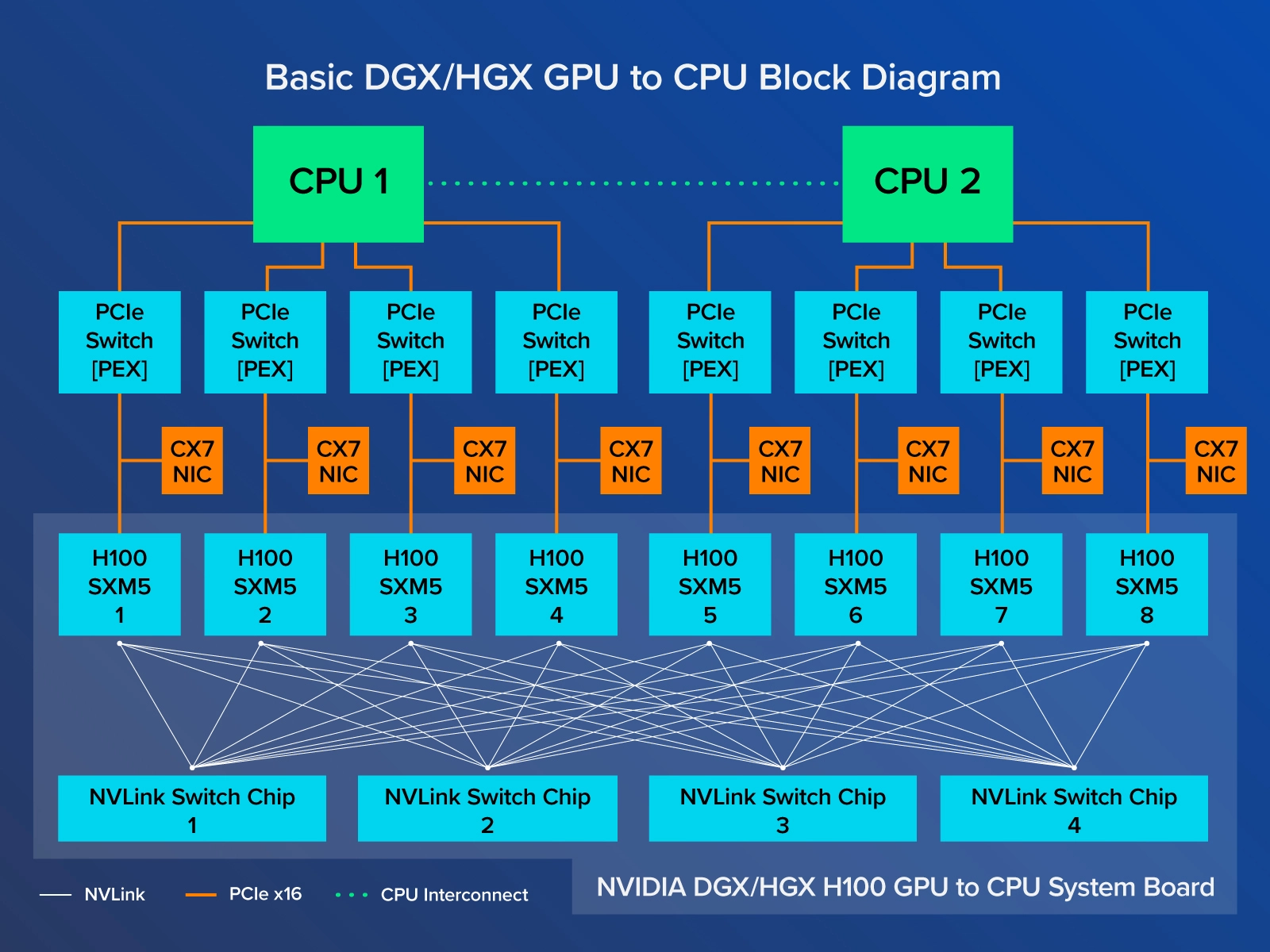

NVIDIA DGX H100 kết nối 8 SXM5 H100 với băng thông 900 GB/giây trên mỗi GPU thông qua 4 NVLink Switch Chip để có tổng băng thông hai chiều hơn 7.2 TB/giây. Mỗi GPU H100 SXM cũng được kết nối với CPU thông qua PCIe để mọi dữ liệu được tính toán bởi bất kỳ GPU nào trong số 8 GPU đều có thể được chuyển tiếp trở lại CPU. Chúng ta sẽ đi qua các sơ đồ kiến trúc sau.

NVIDIA H100 PCIe Form Factor

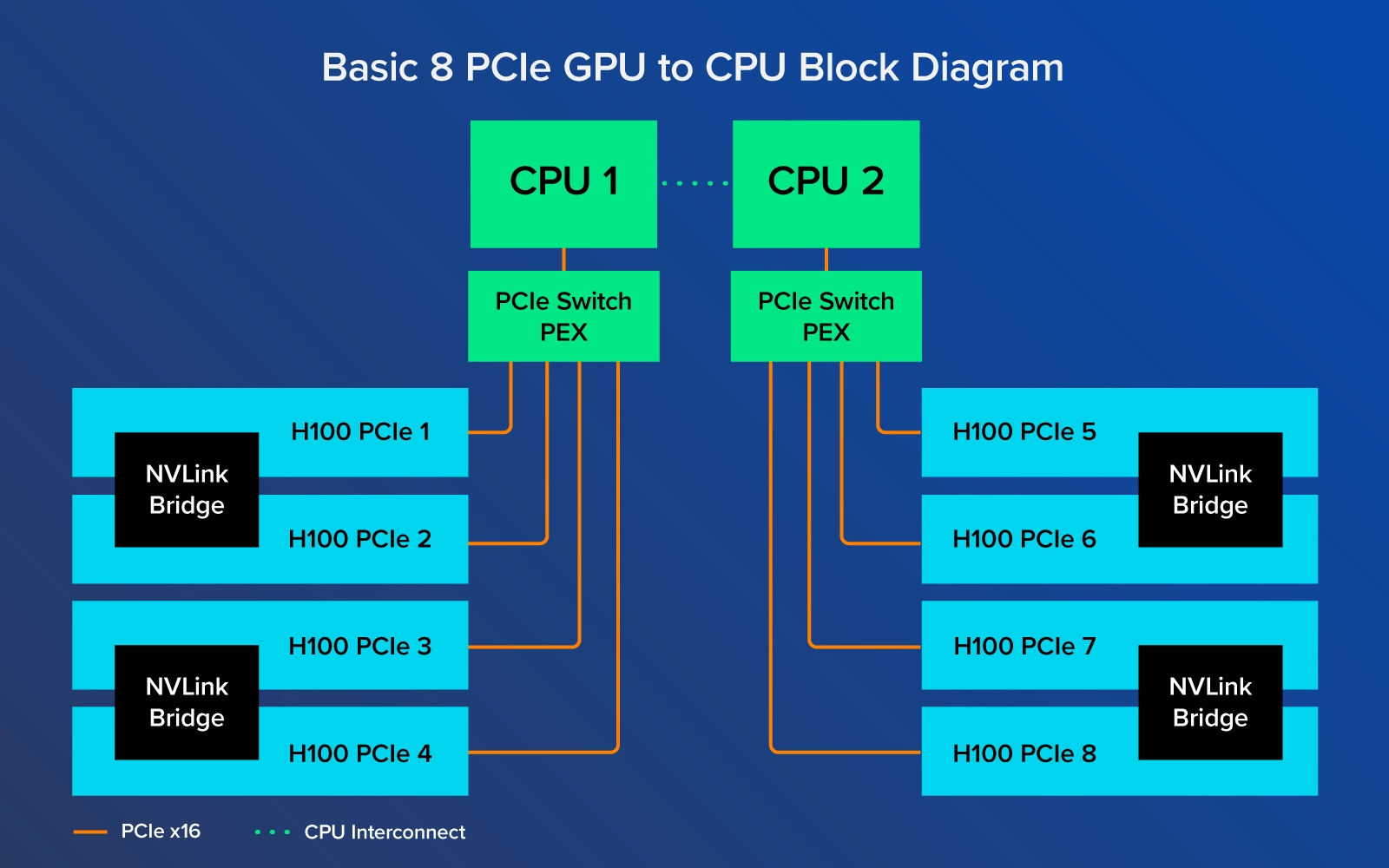

Bạn không thể đạt được băng thông hiệu suất tương tự khi kết nối với các biến thể PCIe qua NVLink Bridges mà H100 PCIe đi kèm. Các cầu nối này chỉ kết nối các GPU với nhau theo cặp để đạt tốc độ 600 GB/giây hai chiều thay vì 900 GB/giây đầy đủ trên bất kỳ GPU nào trong số 8 GPU trong hệ thống.

Đừng hiểu lầm, NVIDIA H100 PCIe là một GPU cực kỳ mạnh mẽ có thể được triển khai một cách dễ dàng. Chúng có thể dễ dàng được đưa vào trung tâm dữ liệu có giá trị nâng cấp với những thay đổi kiến trúc tối thiểu. H100 NVL mở rộng card PCIe mạnh mẽ bằng cách ghép nối chúng lại với nhau để có tổng cộng 188GB HBM3 với hiệu suất đã nêu tương đương với H100 SXM5.

Trong ngành công nghiệp Trung tâm dữ liệu và AI, NVIDIA DGX được coi là vàng theo đúng nghĩa đen. Hệ thống dành cho AI tốt nhất và mạnh mẽ nhất. Nổi bật nhất là OpenAI đào tạo ChatGPT trên hệ thống NVIDIA DGX của họ. Trên thực tế, OpenAI đã được trao tận tay NVIDIA DGX-1 đầu tiên vào năm 2016.

Các tập đoàn lớn đổ xô đến NVIDIA DGX không phải vì nó bóng bẩy mà bởi vì khả năng mở rộng quy mô của nó. Những GPU SXM phù hợp hơn cho việc triển khai mở rộng với 8 GPU H100 được kết nối hoàn toàn với công nghệ NVLink và NVSwitch.

Trong DGX và HGX, cách 8 GPU SXM kết nối khác với PCIe; mỗi GPU được kết nối với 4 NVLink Switch Chip về cơ bản cho phép tất cả các GPU hoạt động như một GPU lớn. Khả năng mở rộng này có thể mở rộng hơn nữa với NVIDIA NVLink Switch System để triển khai và kết nối 256 DGX H100 nhằm tạo ra một nhà máy AI được tăng tốc bởi GPU.

Mặt khác, H100 PCIe như được thấy trong các H100 NVL, là ghép cặp các GPU và được kết nối thông qua NVLink Bridge. GPU 1 chỉ được kết nối trực tiếp với GPU 2, GPU 3 chỉ được kết nối trực tiếp với GPU 4,… GPU 1 và GPU 8 không được kết nối trực tiếp và do đó chỉ có thể giao tiếp dữ liệu qua các lane PCIe, phải sử dụng tài nguyên CPU. Bo mạch hệ thống NVIDIA DGX và HGX có tất cả các GPU SXM được kết nối với nhau thông qua các NVLink Switch Chip, vì thế không bị chậm lại do các hạn chế của bus PCIe khi trao đổi dữ liệu giữa các GPU. Việc gửi dữ liệu trở lại CPU sẽ vẫn diễn ra trên các lane PCIe.

Bằng cách bỏ qua các lane PCIe khi trao đổi dữ liệu giữa các GPU, những GPU SXM H100 tốc độ cao có thể đạt được thông lượng tối đa mà ít bị chậm hơn so với phiên bản PCIe của nó, hoàn hảo để đào tạo các mô hình AI cực lớn – có lượng dữ liệu khổng lồ được sử dụng để đào tạo.

Việc tiêu thụ năng lượng và form factor độc quyền là sự đánh đổi để đạt được hiệu suất cao nhất, có thể kéo dài thời gian đào tạo và suy luận.

Bạn nên chọn gì? H100 SXM hay H100 PCIe?

Nó phụ thuộc vào trường hợp sử dụng của bạn. LLMs và Generative AI yêu cầu hiệu suất cao. Nhưng số lượng người dùng, khối lượng công việc và cường độ đào tạo đóng vai trò quan trọng trong việc chọn hệ thống phù hợp. DGX và HGX của NVIDIA H100 là lựa chọn tốt nhất cho các tổ chức có thể tận dụng hiệu suất tính toán thô và không lãng phí bất kỳ thứ gì. Đào tạo, suy luận và vận hành liên tục có thể nhanh chóng giảm TCO khi sử dụng hết tiềm năng cao nhất của chúng.

NVIDIA DGX có khả năng mở rộng tốt nhất và mang lại hiệu suất không thể sánh được với bất kỳ máy chủ nào khác trong form factor tương tự của nó. Việc liên kết nhiều NVIDIA DGX H100 với NVSwitch Systems có thể mở rộng nhiều DGX H100 thành các SuperPOD cho các mô hình cực lớn.

NVIDIA DGX H100 trong một form factor 8U với Dual Intel Xeon 8480C cung cấp tổng 112 core CPU. NVIDIA DGX không thể tùy chỉnh và là khối xây dựng (building block) cho cơ sở hạ tầng điện toán AI với quy mô đầy đủ. Với NVIDIA DGX, việc đào tạo LLM của bạn có thể được mở rộng một cách dễ dàng. Nhiều DGX hơn đồng nghĩa với việc đào tạo nhanh hơn và triển khai mạnh mẽ hơn.

NVIDIA HGX cung cấp hiệu suất GPU tuyệt vời trong một hệ thống duy nhất mở ra tùy chọn để người dùng tùy chỉnh. Nền tảng HGX là nền tảng có thể tùy chỉnh được cung cấp bởi các đối tác được chọn (như Nhất Tiến Chung) để mang lại hiệu suất mà khách hàng mong muốn – CPU, Memory, Storage, Networking – trong khi vẫn tận dụng cùng một bo mạch hệ thống 8 NVIDIA H100 SXM5 (bao gồm tất cả các tính năng NVLink).

Các hệ thống này có thể đáp ứng nhu cầu của Trung tâm dữ liệu bằng việc lựa chọn NIC của riêng bạn, số core mong muốn trong CPU và đôi khi là lượng lưu trữ bổ sung. NVIDIA HGX tương tự như DGX về khả năng tính toán trong khi vẫn hỗ trợ và phù hợp với nhu cầu đào tạo LLM quy mô lớn của bạn.

Biến thể NVIDIA H100 PCIe dành cho những ai làm việc với các workload nhỏ hơn và muốn có sự linh hoạt tối đa trong việc quyết định số lượng GPU trong hệ thống của mình. Những GPU này vẫn là rất vượt trội khi nói đến hiệu suất. Chúng có số hiệu suất thô thấp hơn một chút nhưng dễ dàng được đưa vào bất kỳ hạ tầng điện toán nào – khiến chúng trở nên hấp dẫn.

H100 PCIe cũng được cung cấp ở các hệ thống với form factor nhỏ hơn như 1U và 2U cho các Trung tâm dữ liệu để có 2 hoặc 4 GPU trong một cấu hình Single hoặc Dual CPU – cung cấp sức mạnh tính toán dành cho phát triển các LLM nhỏ hơn. Tỷ lệ CPU:GPU là 1:1 sẽ tốt cho việc triển khai nhiều khả năng ảo hóa hơn trong suy luận cũng như vô số ứng dụng khác nhau như phân tích.

Nguồn Tổng hợp

Bài viết liên quan

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale

- NVIDIA NVLink Fusion: Tương lai của Trung tâm Dữ liệu AI

- Từ “Sáng tạo” Đến “Hành động”: Khám phá sự khác biệt giữa Generative AI và Agentic AI

- Tìm hiểu các công nghệ mạng của NVIDIA: Nền tảng cho HPC và AI

- NVIDIA NVLink Thế hệ thứ 5: Bước nhảy vọt về băng thông cho kỷ nguyên AI nghìn tỷ tham số

- Mở rộng quy mô cho hạ tầng GenAI on-premise