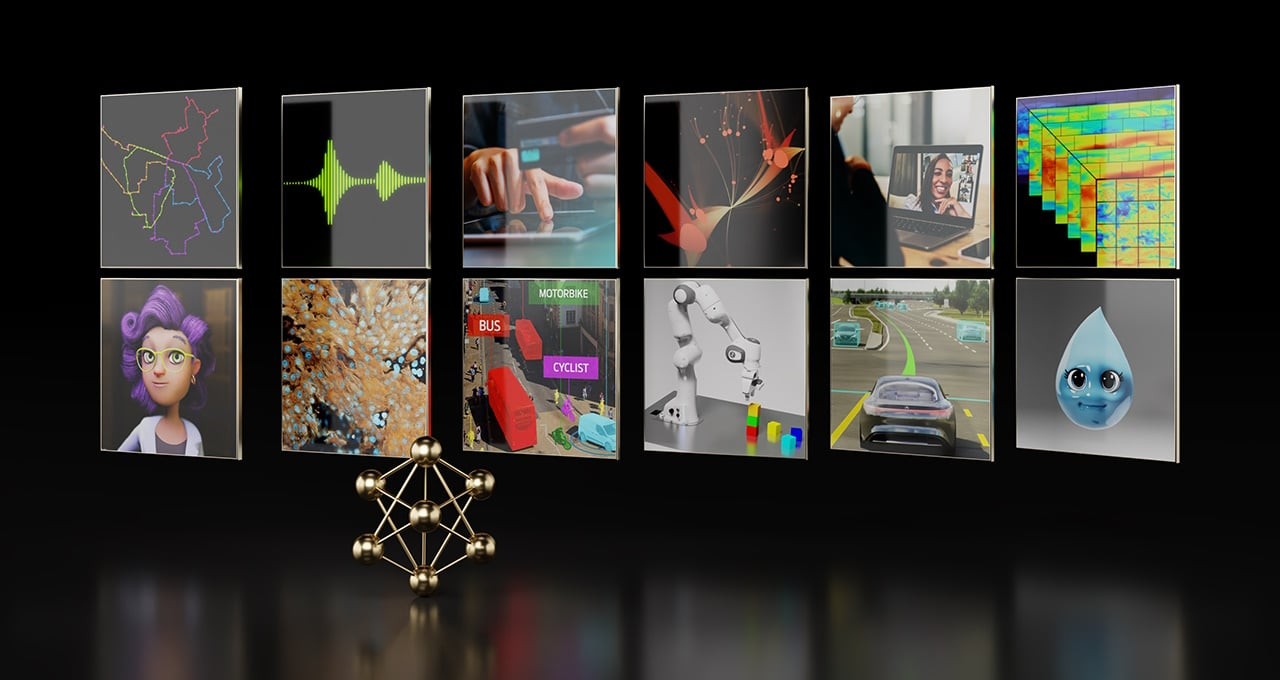

NVIDIA AI Enterprise 5.0 bao gồm các cloud API dành cho suy luận (inference) và những dịch vụ khác, mở đường cho các ứng dụng được AI hỗ trợ.

Nền tảng AI của NVIDIA sẵn có cho mọi doanh nghiệp có tư duy tiến bộ – và nó dễ sử dụng hơn bao giờ hết.

Vừa được ra mắt, NVIDIA AI Enterprise 5.0 bao gồm các dịch vụ dạng microservice của NVIDIA, các container phần mềm có thể tải xuống để triển khai các ứng dụng AI tạo sinh (Generative AI) và điện toán tăng tốc (accelerated computing). Nó có sẵn từ các nhà cung cấp dịch vụ đám mây, nhà xây dựng hệ thống và nhà cung cấp phần mềm hàng đầu – và được sử dụng bởi các khách hàng như Uber.

“Việc áp dụng phần mềm suy luận NVIDIA AI Enterprise của chúng tôi là rất quan trọng để đáp ứng hiệu suất cao mà người dùng mong đợi”. Albert Greenberg, Phó chủ tịch kỹ thuật nền tảng tại Uber cho biết. “Uber tự hào là người đi đầu trong việc áp dụng và sử dụng những cải tiến AI mới nhất, tiên tiến nhất để cung cấp nền tảng dịch vụ khách hàng đặt ra tiêu chuẩn ngành về tính hiệu quả và sáng tạo.”

Microservice tăng tốc phát triển ứng dụng

Các nhà phát triển đang dần chuyển sang microservice như một cách hiệu quả để xây dựng các ứng dụng doanh nghiệp hiện đại ở quy mô toàn cầu. Làm việc từ trình duyệt, họ sử dụng các cloud API để biên soạn ứng dụng có thể chạy trên các hệ thống và phục vụ người dùng trên toàn thế giới.

NVIDIA AI Enterprise 5.0 hiện bao gồm một loạt các microservice – NVIDIA NIM cho triển khai các mô hình AI trong sản xuất và bộ sưu tập microservice NVIDIA CUDA-X bao gồm NVIDIA cuOpt.

Các microservice NIM tối ưu hóa khả năng suy luận cho hàng chục mô hình AI phổ biến của NVIDIA và hệ sinh thái đối tác của mình.

Được hỗ trợ bởi phần mềm suy luận của NVIDIA – bao gồm Triton Inference Server, TensorRT và TensorRT-LLM — NIM giảm thời gian triển khai từ vài tuần xuống còn vài phút. Nó cung cấp khả năng bảo mật và quản lý dựa trên các tiêu chuẩn ngành cũng như khả năng tương thích với các công cụ quản lý cấp doanh nghiệp.

NVIDIA cuOpt là một microservice AI được tăng tốc bởi GPU, đã lập kỷ lục thế giới về tối ưu hóa tuyến đường (route optimization) và có thể hỗ trợ cho việc đưa ra quyết định linh hoạt – giúp giảm chi phí, thời gian và lượng khí thải carbon. Đây là một trong những CUDA-X microservice giúp các ngành đưa AI vào sản xuất.

Nhiều khả năng khác đang được thực hiện. Ví dụ: NVIDIA RAG LLM operator – hiện có thể truy cập sớm và được mô tả chi tiết hơn tại đây – sẽ chuyển đổi các co-pilot và các ứng dụng GenAI khác sử dụng Retrieval-Augmented Generation (RAG) từ thử nghiệm sang sản xuất mà không cần viết lại bất kỳ dòng code nào.

NVIDIA microservice đang được các nhà cung cấp nền tảng an ninh mạng và ứng dụng hàng đầu như CrowdStrike, SAP và ServiceNow áp dụng.

Nhiều công cụ và tính năng hơn

Ba bản cập nhật khác trong phiên bản 5.0 rất đáng chú ý.

Nền tảng này hiện tích hợp NVIDIA AI Workbench, một bộ công cụ dành cho nhà phát triển để nhanh chóng tải xuống, tùy chỉnh và chạy các dự án GenAI. Phần mềm hiện đã có sẵn và được hỗ trợ với NVIDIA AI Enterprise license.

Phiên bản 5.0 hiện cũng hỗ trợ Red Hat OpenStack Platform, môi trường mà hầu hết các công ty Fortune 500 sử dụng để tạo các dịch vụ private và public cloud. Được duy trì bởi Red Hat, nó cung cấp cho các nhà phát triển một tùy chọn quen thuộc để xây dựng những môi trường điện toán ảo. IBM Consulting sẽ giúp khách hàng triển khai những khả năng mới này.

Ngoài ra, phiên bản 5.0 mở rộng hỗ trợ cho nhiều loại GPU NVIDIA, phần cứng mạng và phần mềm ảo hóa mới nhất.

Sẵn sàng để chạy ở bất cứ đâu

Nền tảng NVIDIA AI nâng cao dễ dàng truy cập hơn bao giờ hết.

Các microservice NIM và CUDA-X cũng như tất cả các tính năng 5.0 sẽ sớm có mặt trên AWS, Google Cloud, Microsoft Azure và Oracle Cloud .

Đối với những ai thích chạy code trong trung tâm dữ liệu của họ, VMware Private AI Foundation với NVIDIA sẽ hỗ trợ phần mềm để nó có thể được triển khai trong các trung tâm dữ liệu được ảo hoá của khách hàng Broadcom.

Các công ty có tùy chọn chạy NVIDIA AI Enterprise trên Red Hat OpenShift, cho phép họ triển khai trên môi trường ảo hóa hoặc vật lý. Nó cũng được hỗ trợ trên Charmed Kubernetes của Canonical cũng như Ubuntu.

Ngoài ra, nền tảng AI sẽ là một phần của phần mềm có sẵn trên các máy chủ HPE ProLiant từ Hewlett Packard Enterprise (HPE). Giải pháp điện toán doanh nghiệp của HPE dành cho Generative AI – xử lý suy luận và tinh chỉnh mô hình – sử dụng NVIDIA AI Enterprise.

Ngoài ra, Anyscale, Dataiku và DataRobot – 3 nhà cung cấp phần mềm hàng đầu để quản lý các hoạt động Machine Learning – sẽ hỗ trợ NIM trên nền tảng của họ. Họ tham gia hệ sinh thái NVIDIA gồm hàng trăm đối tác MLOps, bao gồm Microsoft Azure Machine Learning, Dataloop AI, Domino Data Lab và Weights & Biases.

Dù họ truy cập nó như thế nào, người dùng NVIDIA AI Enterprise 5.0 vẫn có thể hưởng lợi từ phần mềm an toàn, sẵn sàng cho sản xuất và được tối ưu hóa về hiệu suất. Nó có thể được triển khai linh hoạt cho các ứng dụng trong trung tâm dữ liệu, đám mây, trên máy trạm hoặc ở biên mạng.

NVIDIA AI Enterprise có sẵn thông qua các nhà cung cấp hệ thống hàng đầu, bao gồm Cisco, Dell Technologies, HP, HPE, Lenovo và Supermicro.

Lắng nghe câu chuyện thành công tại GTC

Người dùng sẽ chia sẻ trải nghiệm của họ với phần mềm tại NVIDIA GTC.

Giám đốc thông tin kỹ thuật số của ServiceNow, Chris Bedi sẽ phát biểu trong một phiên về việc khai thác tiềm năng của AI. Trong một buổi nói chuyện riêng, phó chủ tịch Sản phẩm AI của ServiceNow, Jeremy Barnes sẽ chia sẻ về cách sử dụng NVIDIA AI Enterprise để đạt được năng suất tối đa cho nhà phát triển.

Các giám đốc điều hành của BlackRock, Medtronic, SAP và Uber sẽ thảo luận về công việc của họ trong lĩnh vực tài chính, chăm sóc sức khỏe, phần mềm doanh nghiệp và hoạt động kinh doanh bằng cách sử dụng nền tảng NVIDIA AI.

Ngoài ra, các giám đốc điều hành của ControlExpert, nhà cung cấp ứng dụng toàn cầu cho các công ty bảo hiểm ô tô có trụ sở tại Đức, sẽ chia sẻ cách họ phát triển giải pháp quản lý khiếu nại được hỗ trợ bởi AI bằng phần mềm NVIDIA AI Enterprise.

Họ nằm trong số các công ty đang phát triển được hưởng lợi từ công việc đánh giá hàng trăm dự án GenAI bên trong và bên ngoài của NVIDIA – tất cả đều được tích hợp vào một gói duy nhất đã được kiểm tra độ ổn định và bảo mật.

Và có được bức tranh toàn cảnh từ NVIDIA CEO và founder Jensen Huang trong bài phát biểu quan trọng tại GTC của mình.

NVIDIA blog

Bài viết liên quan

- Infortrend Enterprise Cloud – Giải pháp điện toán tập trung cho phát triển AI

- NVIDIA: Công nghệ Silicon Photonics và Co-Packaged Optics – Thay đổi cuộc chơi trong kỷ nguyên AI và HPC

- Từ “Sáng tạo” Đến “Hành động”: Khám phá sự khác biệt giữa Generative AI và Agentic AI

- Mở rộng quy mô cho hạ tầng GenAI on-premise

- Sovereign AI là gì?

- Điện toán đám mây: Những xu hướng mới sẽ rõ nét hơn trong năm 2025