Các mô hình ngôn ngữ lớn (LLM) như ChatGPT đã tạo nên một cơn địa chấn trong làng công nghệ, nhưng những người anh em “nhỏ con” hơn, các mô hình ngôn ngữ nhỏ – Small Language Model (SLM), đang âm thầm trỗi dậy. Liệu SLM có phải là lời giải cho bài toán chi…

AI – HPC

Lựa chọn hạ tầng lưu trữ cho AI: NAS, SAN, hay Object Storage – Đâu là nền tảng tối ưu?

Trí tuệ nhân tạo (AI) và học máy (Machine Learning) không còn là khái niệm tương lai mà đã trở thành động lực cốt lõi cho sự đổi mới trong mọi ngành công nghiệp. Tuy nhiên, để các mô hình AI có thể hoạt động hiệu quả, chúng đòi hỏi một tài nguyên cực kỳ…

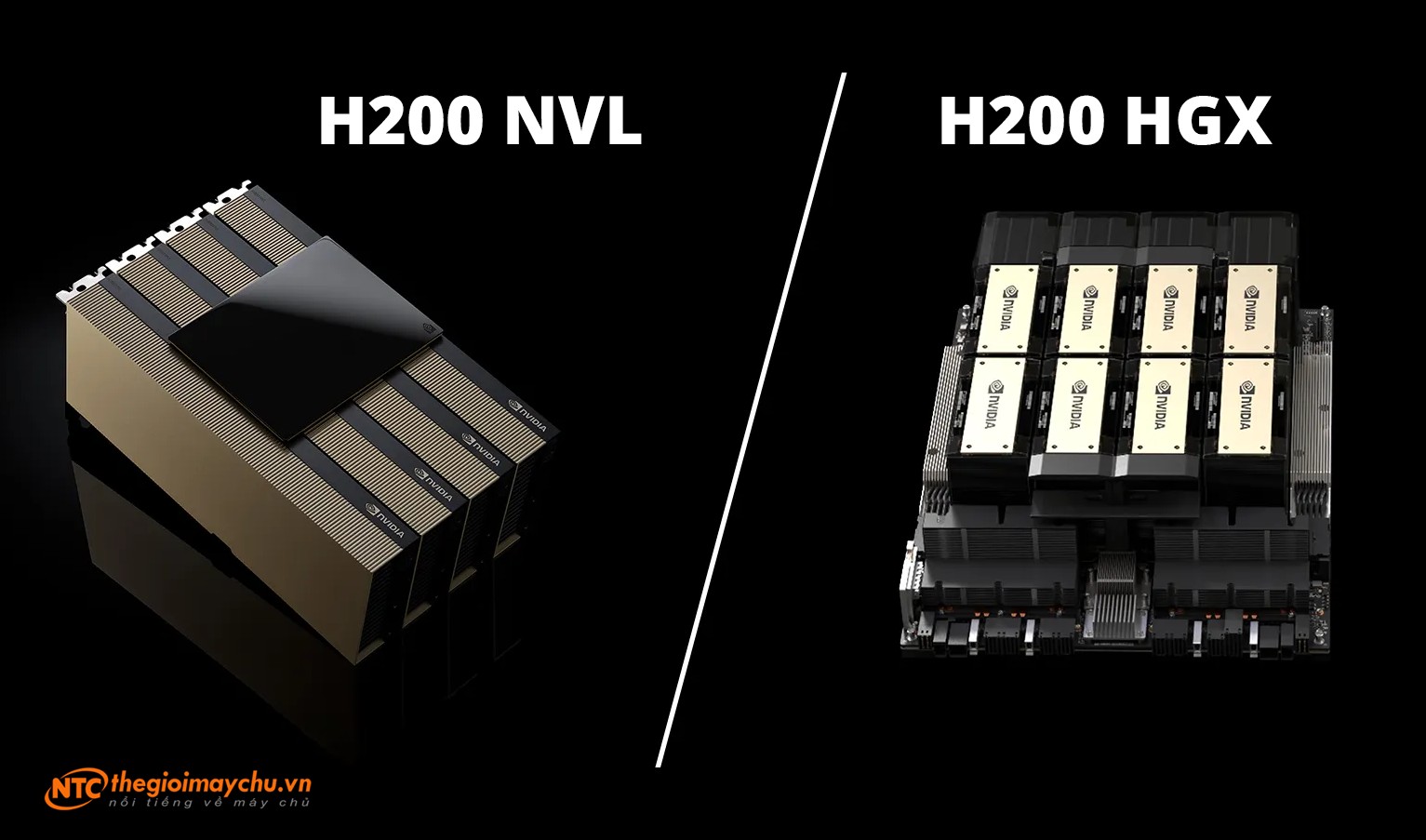

So sánh sự khác biệt giữa NVIDIA H200 NVL và NVIDIA H200 HGX

NVIDIA HGX™ H200 mang lại hiệu suất tối đa cho môi trường AI và HPC, trong khi H200 NVL cung cấp giải pháp làm mát bằng không khí, tiêu thụ điện năng thấp hơn với 1, 2, 4 hoặc 8 GPU PCIe được kết nối bằng NVIDIA® NVLink®, mang lại tính linh hoạt cho các…

Mở rộng quy mô cho hạ tầng GenAI on-premise

Nhu cầu GPU của AI tạo sinh AI đã trở thành một thành phần quan trọng của chiến lược kinh doanh hiện đại. Cho dù đó là đào tạo và tinh chỉnh các mô hình cá nhân của riêng bạn hay sử dụng suy luận AI để chuyển đổi hoạt động kinh doanh, AI là…

So sánh NVIDIA RTX PRO 6000 Blackwell Server Edition và NVIDIA L40S

Tổng quan NVIDIA gần đây đã cho ra mắt mẫu GPU hiệu suất cao RTX PRO 6000 Blackwell Server Edition, một thế hệ tiếp nối trong dòng GPU chuyên nghiệp của hãng, theo sau mẫu GPU máy chủ L40S PCIe đình đám đã được sử dụng rộng rãi. Cần lưu ý để tránh nhầm lẫn…

Hơn 20 mẫu máy chủ Supermicro được tối ưu hóa cho dòng GPU mới NVIDIA RTX PRO 6000 Blackwell hiện đã sẵn sàng nhận đặt hàng

Danh mục các máy chủ Supermicro với GPU NVIDIA RTX PRO 6000 Blackwell có chứng nhận NVIDIA Certified-System. Supermicro hợp tác phát triển các thiết kế mới được chứng nhận cho thiết kế của NVIDIA Enterprise AI Factory dựa trên Máy chủ RTX PRO và hệ thống NVIDIA HGX B200. Hệ thống UP 4-GPU mới…

CPU NVIDIA Grace C1 được hỗ trợ rộng rãi cho điện toán biên, ngành viễn thông và các hệ thống lưu trữ

Tuần này tại triển lãm thương mại COMPUTEX ở Đài Bắc, NVIDIA đang nhấn mạnh đà phát triển đáng kể cho CPU Grace C1 mới của mình, với sự ủng hộ mạnh mẽ từ các đối tác sản xuất thiết kế gốc (ODM) chủ chốt. Dòng sản phẩm CPU NVIDIA Grace đang mở rộng, bao…

AI Blueprint: Nền tảng phân tích video cho các ứng dụng tìm kiếm và tóm tắt video

Thời đại của công cụ phân tích video bằng AI đã đến. Video, một đặc trưng của thế giới số hiện đại, chiếm hơn một nửa tổng lưu lượng dữ liệu toàn cầu. Không chỉ thống trị trong lĩnh vực truyền thông, video ngày càng trở nên thiết yếu đối với doanh nghiệp ở nhiều…

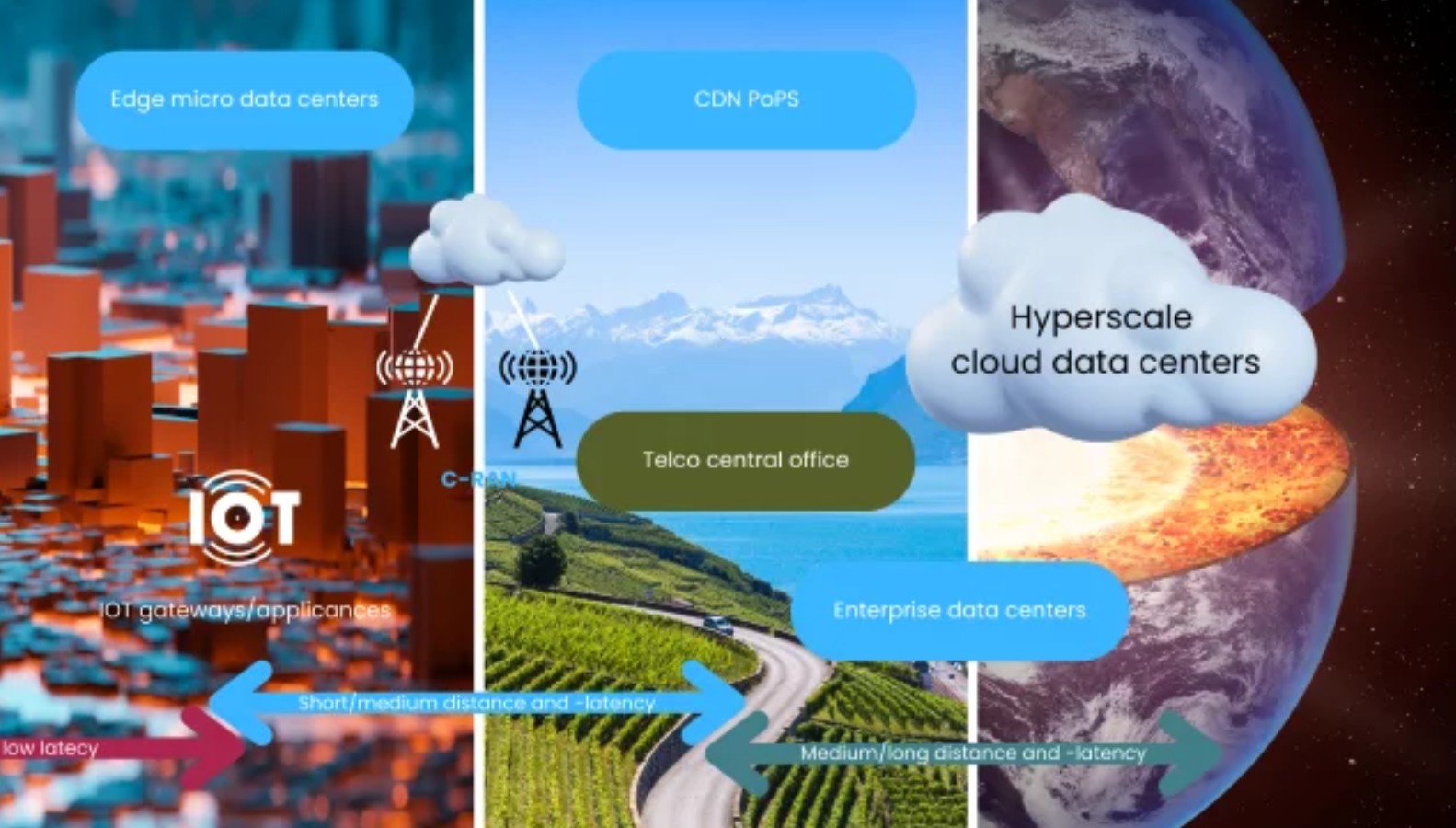

Một số ý tưởng ứng dụng AI theo mô hình từ lõi đến biên (Core-to-Edge)

Xây dựng các giải pháp AI từ lõi đến biên là một trong những hướng phát triển kinh doanh nằm ở mặt trận tiên phong trong nhu cầu kinh doanh hiện đại. Nó giúp các tổ chức doanh nghiệp có được thông tin nắm bắt theo thời gian thực, tăng cường quyền riêng tư và…

Khoa học đời sống: Khi đột phá nằm trong biển dữ liệu và chìa khóa mang tên hạ tầng AI

Trong thế giới khoa học đời sống, mỗi khám phá vĩ đại thường khởi nguồn từ một khoảnh khắc “eureka!” – một cái nhìn sâu sắc bất ngờ hé lộ những điều chưa từng được biết đến. Đó có thể là việc xác định một biến thể di truyền hiếm hoi gây bệnh, tìm ra…