Kiến trúc NVIDIA Ampere

Thành phần cốt lõi của AI và HPC trong trung tâm dữ liệu thế hệ mới

Các nhà khoa học, nhà nghiên cứu và kỹ sư – những “Da Vinci” và “Einstein” của thời đại chúng ta – đang làm việc để giải quyết các thách thức quan trọng nhất của thế giới về dữ liệu lớn, khoa học, các ngành công nghiệp với AI và điện toán hiệu năng cao (HPC). Trong khi đó, các doanh nghiệp và thậm chí toàn bộ các ngành công nghiệp đang tìm cách khai thác sức mạnh của AI để rút ra những hiểu biết mới từ các bộ dữ liệu khổng lồ, cả tại chỗ và trên đám mây. Kiến trúc NVIDIA Ampere, được thiết kế cho thời đại điện toán linh hoạt (elastic computing), mang đến bước nhảy vọt kế tiếp với việc cung cấp khả năng tăng tốc chưa từng thấy ở mọi quy mô, cho phép các nhà phát kiến này thực hiện công việc của mình.

Đột phá trong đổi mới

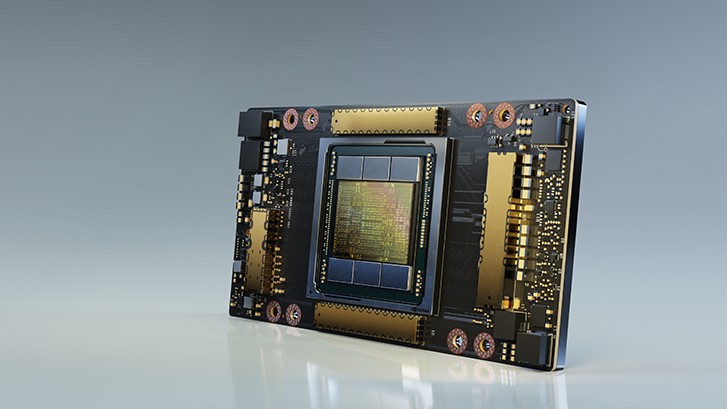

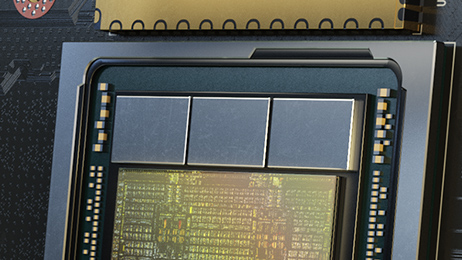

Được chế tạo với 54 tỷ transistors, NVIDIA Ampere là con chip 7 nanomet (nm) lớn nhất từng được chế tạo và có sáu cải tiến đột phá quan trọng.

Tensor Core thế hệ thứ 3

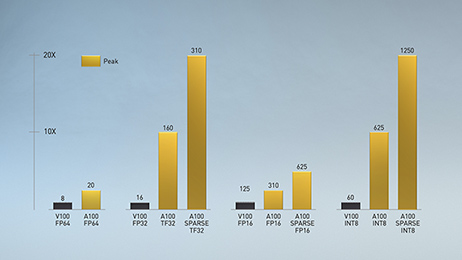

Được giới thiệu lần đầu tiên trong kiến trúc NVIDIA Volta™, công nghệ NVIDIA Tensor Core đã mang đến sự tăng tốc đáng kinh ngạc cho AI, giảm thời gian đào tạo từ vài tuần xuống hàng giờ và cung cấp khả năng tăng tốc lớn để suy luận. Kiến trúc NVIDIA Ampere được xây dựng dựa trên những cải tiến này bằng cách mang đến mức độ chính xác mới, Tensor Float (TF32) và Floating Point 64 (FP64), để tăng tốc và đơn giản hóa việc áp dụng AI, đồng thời mở rộng sức mạnh của Tensor Cores cho HPC.

TF32 hoạt động giống như FP32 trong khi cung cấp tốc độ lên tới 20 lần cho AI mà không yêu cầu bất kỳ yêu cầu thay đổi code nào. Sử dụng NVIDIA Automatic Mixed Precision, các nhà nghiên cứu có thể đạt được hiệu suất gấp 2 lần với automatic mixed precision và FP16 chỉ thêm một vài dòng code. Và với sự hỗ trợ cho bfloat16, INT8 và INT4, các Tensor Core trong GPU NVIDIA A100 Tensor Core tạo ra một hệ thống tăng tốc cực kỳ linh hoạt cho cả đào tạo và suy luận AI. Mang sức mạnh của Tensor Core cho HPC, A100 cũng cho phép các phép toán ma trận ở độ chính xác FP64 đầy đủ, được chứng nhận bởi IEEE.

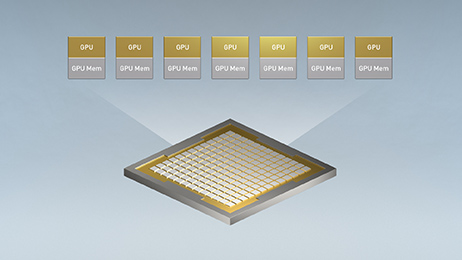

Multi-Instance GPU (MIG)

Mọi ứng dụng AI và HPC đều có thể được hưởng lợi từ việc tăng tốc, nhưng không phải mọi ứng dụng đều cần hiệu năng của một hệ thống GPU A100 đầy đủ. Với MIG, mỗi A100 có thể được phân chia thành bảy GPU ảo (GPU instance), được cô lập và bảo mật hoàn toàn ở cấp độ phần cứng với bộ nhớ băng thông cao, bộ nhớ cache và core xử lý. Giờ đây, các nhà phát triển có thể truy cập khả năng tăng tốc đột phá cho tất cả các ứng dụng của họ, cà quy mô lớn và nhỏ và được đảm bảo về mặt QoS. Và các quản trị viên CNTT có thể cung cấp khả năng tăng tốc GPU đúng nhu cầu để sử dụng tối ưu và mở rộng quyền truy cập cho mọi người dùng và ứng dụng trên cả môi trường ảo và vật lý.

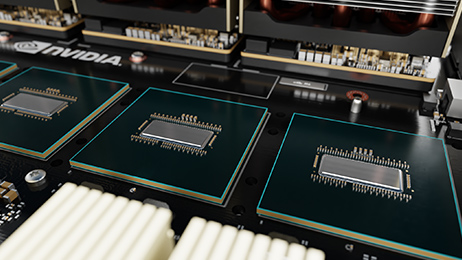

NVLink thế hệ thứ ba

Các ứng dụng mở rộng trên nhiều GPU đòi hỏi dữ liệu di chuyển cực nhanh. Thế hệ thứ ba của NVIDIA NVLink trong A100 tăng gấp đôi băng thông trực tiếp từ GPU đến GPU lên đến 600 GB mỗi giây (GB/s), cao hơn gần 10 lần so với PCIe Gen4. Khi được ghép nối với thế hệ NVIDIA NVSwitch mới nhất, tất cả các GPU trong máy chủ có thể nói chuyện với nhau ở tốc độ NVLink đầy đủ để truyền dữ liệu cực nhanh.

NVIDIA DGX™ A100 và các máy chủ từ các nhà sản xuất máy tính hàng đầu khác tận dụng công nghệ NVLink và NVSwitch thông qua các baseboard NVIDIA HGX™ A100 để mang lại khả năng mở rộng lớn hơn cho khối lượng công việc HPC và AI.

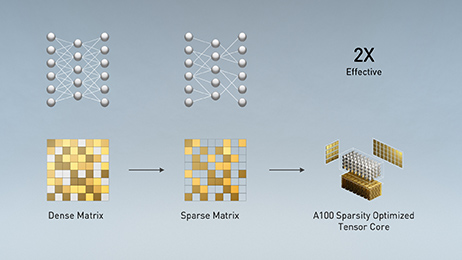

Sự thưa thớt có cấu trúc (Structural Sparsity)

Các mạng AI hiện đại có quy mô rất lớn và ngày càng mở rộng, với hàng triệu và trong một số trường hợp là hàng tỷ tham số. Không phải tất cả các tham số này đều cần thiết cho các phép dự đoán và suy luận chính xác, và một số có thể được chuyển đổi thành zero để tạo ra các mô hình mà “sự thưa thớt” mà không ảnh hưởng đến độ chính xác. Các Tensor Core trong A100 có thể cung cấp hiệu suất cao hơn gấp 2 lần cho các mô hình thưa thớt. Mặc dù tính năng thưa thớt dễ dàng mang lại lợi ích cho suy luận AI, nó cũng có thể được sử dụng để cải thiện hiệu suất đào tạo mô hình.

Bộ nhớ thông minh và nhanh hơn

A100 đang mang đến số lượng lớn khả năng xử lý cho các trung tâm dữ liệu. Để giữ cho các công cụ điện toán này được sử dụng đầy đủ, nó có băng thông bộ nhớ lên đến 1,6 terabyte mỗi giây (TB/s), tăng 67% so với thế hệ trước. Ngoài ra, A100 có bộ nhớ trên chip nhiều hơn đáng kể, bao gồm bộ nhớ cache level 2 40 MB, lớn hơn 7 lần so với thế hệ trước, để tối đa hóa hiệu suất tính toán.

Tăng tốc tập trung ở ngoài rìa (Edge)

Sự kết hợp giữa kiến trúc NVIDIA Ampere và ConnectX-6 Dx SmartNIC của NVIDIA Mellanox trong NVIDIA EGX™ A100 mang đến khả năng tính toán và tăng tốc mạng chưa từng có để xử lý lượng dữ liệu khổng lồ được tạo ra ở rìa mạng. Mellanox SmartNIC bao gồm khả năng giảm tải bảo mật với khả năng decrypt ở tốc độ đường truyền lên tới 200 gigabit mỗi giây (Gb/s) và công nghệ GPUDirect™ cho phép chuyển tải video frames trực tiếp vào bộ nhớ GPU để xử lý AI. Với EGX A100, các doanh nghiệp có thể tăng tốc việc triển khai AI ở rìa an toàn và hiệu quả hơn rất nhiều.

TÌM HIỂU THÊM VỀ NVIDIA EGX A100

Giới thiệu về NVIDIA

NVIDIA với xuất phát điểm từ hãng sản xuất card tăng tốc đồ họa từ năm 1993, đến nay, hãng đã chuyển mình thành công ty chuyên cung cấp giải pháp điện toán Data Center hiệu năng cao, siêu máy tính cho AI và phân tích dữ liệu.

Nhất Tiến Chung (NTC) là nhà cung cấp các giải pháp hạ tầng CNTT, Điện toán Hiệu năng cao (HPC) cho AI với kinh nghiệm kinh doanh phần cứng từ năm 2005. Chúng tôi là nhà phân phối chính thức của NVIDIA cho các hệ thống điện toán hiệu năng cao dựa trên GPU bao gồm DGX A100, DGX Station A100 và hệ thống cụm siêu máy tính DGX SuperPOD với sức mạnh lưu trữ song song của DDN và mạng tốc độ cao từ Mellanox.